Frank Buckler

Das Ende der Kennzahlen-Illusion

Mehr Marge, mehr Absatz, mehr Effizienz –

durch einen digitalen Spürhund

Inhalt

Alltagswissen und andere Mythen

Mit richtigen Methoden Ursachen aufspüren

Digitale Spürhunde im Einsatz: Anwendungsfelder multivariater Ursachenanalysen

Einkauf und Personalmanagement

Strategische Unternehmensführung

Was macht einen guten digitalen Spürhund aus: Die Wahl der richtigen Methode

Wie Kolumbus sein: Entdecken können

Erkennen, was da ist: Komplexität entdecken können

Mit dem auskommen, was man hat: Mit kleinen Stichproben umgehen können

Universal Structure Modeling und die Software NEUSREL

Umsetzen: Die Befreiung aus der Kennzahlen-Illusion

KAPITEL 1

Alltagswissen und andere Mythen

Noch immer klingt mir die Mahnung meiner Mutter in den Ohren: „Junge, trink nicht so viel Kaffee! Das entwässert.“ Aber ich liebe doch Kaffee. So ein Mist!

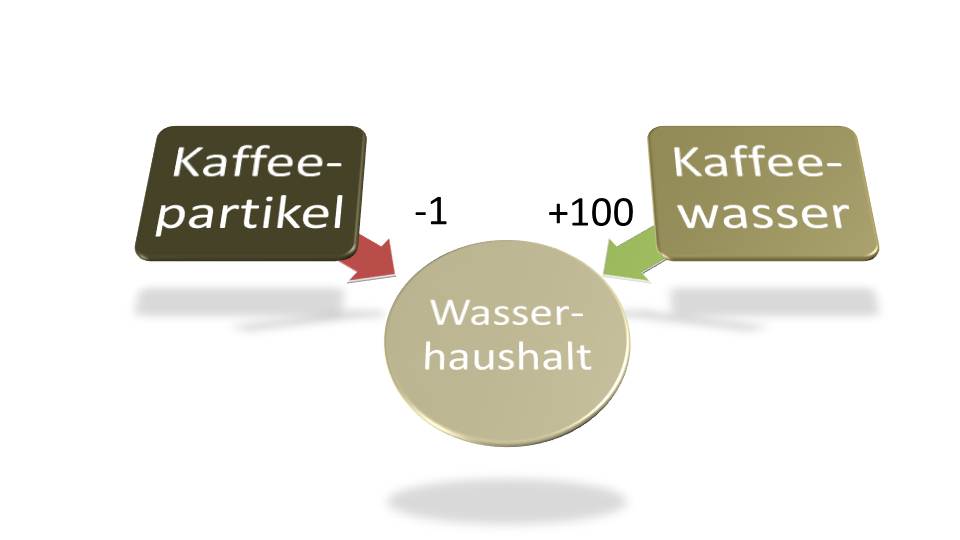

Als ich zuletzt durch das abendliche TV-Programm zappe, bleibe ich bei Galileo hängen – eine Art Sendung mit der Maus für Erwachsene. Es geht um Kaffee und die als Allgemeinwissen verkleideten Scheinwahrheiten, die mir meine Mutter immer wieder mit auf den Weg gibt. Tatsächlich wirkt ein Stoff im Kaffee etwas entwässernd. Dieser Effekt ist jedoch minimal. Außerdem besteht eine Tasse Kaffee fast schließlich aus aromatisiertem Wasser. Diese Flüssigkeitsmenge überkompensiert bei Weitem den Wasserverlust, der durch die Kaffeepartikel ausgelöst wird.

Witzig. Ich hatte es meiner Mutter geglaubt. Warum eigentlich? Ich habe doch schon tausendfach Kaffee getrunken und damit meine ganz persönliche Validierungsstudie durchgeführt. Mir war es nicht aufgefallen.

Nun sah ich endlich, warum meiner Mutter die Kaffeeschelte ein so großes Anliegen war. Als mein Vater noch arbeitete, bestand die Flüssigkeitszufuhr meines Vaters während der Arbeit fast ausschließlich aus Kaffee oder Tee. Die scheinbare Folge waren Wassermangel, häufige Kopfschmerzen, ein ständig trockener Mund und andere Dinge, die damit einhergingen. Als meine Mutter von der entwässernden Wirkung des Kaffees hörte, war der Schuldige dingfest gemacht. Der Kaffeekonsum wurde massiv reduziert, und stattdessen wurde Wasser getrunken. Das Problem schien gelöst, und eine Vermutung verfestigte sich zu Wissen.

Tatsächlich entwässert Kaffee nicht. Nur neigen manche Leute dazu, stundenlang kein Wasser zu sich zu nehmen, wenn Sie Kaffee trinken. Schon komisch, wie relativ einfaches, aber falsches Wissen von uns im Alltag nicht erkannt wird. Zum Glück passiert das nur im Privatleben – im Geschäftsleben sind ja Profis am Werk. Oder?

Damit aber nicht genug. Galileo lief an jenem Abend weiter und nahm einen weiteren Mythos meiner Jugend aufs Korn. Es ging um den Glauben, dass Kälte eine Erkältung auslöst. Alte Erinnerungen wurden wach: „Junge, föhn dir die Haare. Du holst dir sonst den Tod!“

Föhnen war uncool und ein absolutes No-go zu meiner Zeit. Ein weiterer Klassiker war die liebevoll gemeinte Mischung aus Anregung und Befehl: „Zieh den Schal an, Junge. Es ist kalt draußen!“ Auf meine Autonomie pochend, missachtete ich diesen Rat schon aus Prinzip. Denn ich entscheide bitteschön immer selbst, wann ich einen Schal anziehe!

Meistens ging es auch gut. Ich wurde nicht krank. Ein klarer Beweis, dass die Jugend oft schlauer ist als die weisen Erwachsenen. Oder? Meine Mutter sah das naturgemäß anders. Wenn ich trotzdem einmal krank wurde, lag es an meiner Nachlässigkeit beim Trockenrubbeln des Kopfes, beim Tragen meiner Mütze und beim Anlegen meines Schals. Andere Ursachen waren für sie ausgeschlossen.

Gespannt folgte ich der Sendung, die mir früher nur durch langweilige Banalitäten aufgefallen war. Warum machen nasse Haare im Frühlingswind nicht krank? Die Investigativ-Journalisten traten mit einem Experiment den Beweis an. Einige Freiwillige stellten sich eine Stunde lang in ein kaltes Wasserbad. Keiner davon wurde krank. Das ist erstaunlich. Denn wenn eines klar ist, dann dass Unterkühlung doch krank macht. Ist das aber wirklich so? Leider und zum Glück: nein. Einem gesunden Körper macht das absolut nichts aus!

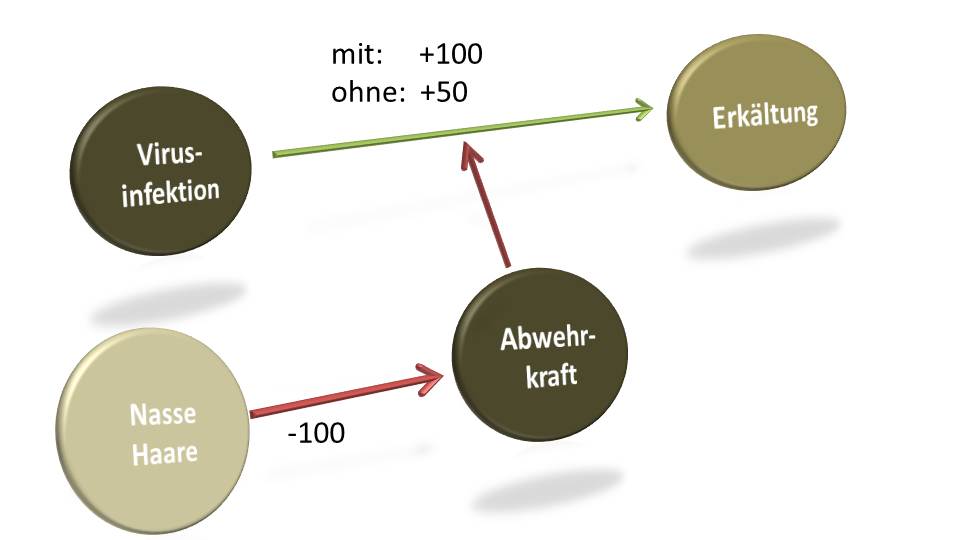

Dennoch enthält dieser Satz auch eine Einschränkung: „gesund“. Unterkühlung schwächt die Abwehrkräfte gegen viralen Befall. Haben wir uns mit Viren infiziert, so kommt unser Abwehrsystem oft damit zurecht und eliminiert die Eindringlinge, bevor sie sich zu stark vermehren. Kommen aber Kälte, Stress oder irgendwelche Gifte hinzu, ist die Wahrscheinlichkeit höher, dass wir uns einen Infekt zuziehen. Das ganze heißt dann zwar Erkältung, hat aber nur sehr bedingt etwas mit Kälte zu tun.

Viele werden nun einwenden: „Na ja, das Vermeiden von Kälte reduziert zumindest einen Risikofaktor. Daher ist die Empfehlung richtig.“ Natürlich schadet die Empfehlung nicht und verhindert in wenigen Fällen die Krankheit. Gegenüber der Anwendung richtigen Wissens jedoch verursacht die Empfehlung Einschränkungen und Umstände, die man im Geschäftskontext Kosten nennen würde. Wir kaufen Schal und Mütze, unter denen wir häufig unangenehm schwitzen, obwohl das Risiko einer Infektion extrem gering ist, wenn wir ansonsten gut auf uns achten. Vitaminreiche Ernährung, ausreichend Schlaf und Flüssigkeitszufuhr, Schutz der Schleimhäute vor Austrocknung und vieles mehr – wenn wir Dinge tun, die der Körper ohnehin gut gebrauchen kann, können wir uns das Wolldiktat sparen.

„Spannend“, denke ich mir: „Schon wieder hatte mich meine Mutter beschwindelt.“ Zugegeben, Sie wusste es nicht besser. Doch warum nicht? Derlei Dinge erleben wir im Schnitt sicher zwei- bis dreimal im Jahr. Man sollte doch in der Lage sein, aus eigenen Erfahrungen valides Wissen abzuleiten? Wahrscheinlich aber klappt das nicht, weil wir alle nur Laien sind. Wären wir Profis in der Wissensgewinnung, würde das nicht passieren. Manager zum Beispiel scheinen Profis darin zu sein, während ihrer Berufslaufbahn Wissen darüber anzuhäufen, wie man erfolgreich ein Unternehmen oder dessen Teilbereiche führt. Zusätzlich bekommen sie ja schon das geballte Know-how anderer Profis im Studium vermittelt. Daher kann dies im Management sicher nicht passieren. Oder doch?

Erleuchtet und nachdenklich zugleich zappte ich weiter.

Einige Tage später wurde ich krank. Obwohl ich immer brav die Haare föhne. Ich machte mich auf zu diesem neuen Allgemeinmediziner, den mir ein Freund wärmstens empfohlen hatte. Der Termin war kurz und schmerzlos – wie am Fließband eben, so wie bei all diesen Feld-Wald-und-Wiesen-Krankheiten. Überrascht hatte mich dann aber doch eine Art „FAQ-Notiz“, die ich zum Abschluss in die Hand gedrückt bekam. Neben dem enormen Effizienzgewinn, der dieser Beratungsmethode innewohnt, überraschte mich der Inhalt. Darin stand unter anderem zu lesen: „Trinken Sie keinen Orangensaft. Trinken Sie keine Milch.“ Wissbegierig, wie ich nun mal bin, fragte ich nach. „Das widerspricht doch jedem logischen Menschenverstand. Orangensaft hat Vitamine und muss gut sein. Milch ist sowieso immer super. Das sagt nicht nur die Werbung. Auch endlose Studien der Milchlobby beweisen das“, gab ich extrem logisch zu bedenken.

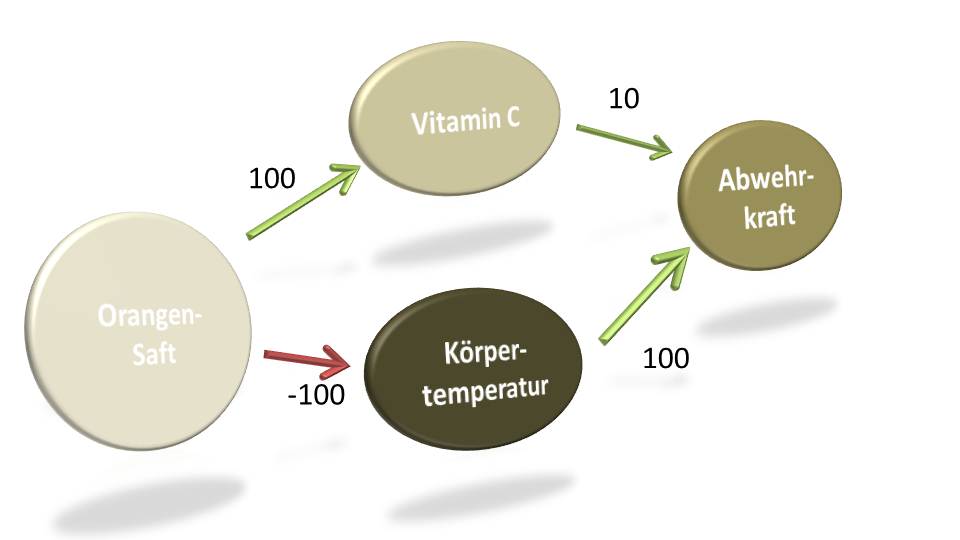

Okay, die Milch ist nur ein Randthema. Hierzu meinte der Arzt lapidar, dass Milch verschleimt und bei einer Erkältung heiser macht. Aber was ist mit dem Orangensaft? Der Arzt erklärte mir: „Klar, Vitamine sind schon drin. Aber Vitamin C ist gut für die Stärkung der Abwehrkräfte vor der Infektion, wenn auch das Ausmaß, in dem Vitamin C wirklich hilft, umstritten ist. Während der Infektion hilft es dann kaum noch. Viel schlimmer ist jedoch, dass kalte Getränke auskühlen. Das nimmt dem Körper die Energie, die er zur Virenabwehr benötigt. Warm halten, Heißes trinken und ausruhen sind daher die Geheimwaffen zur Genesung“, schilderte er überaus nachvollziehbar.

„Puh, schon wieder alles Kokolores, was meine Mutter mir gepredigt hatte.“ Obwohl – nicht ganz. Sie hatte stets darauf geachtet, dass ich Bettruhe bekam. Aber auch das war damals natürlich eine offene Kriegserklärung gegen meine Persönlichkeitsrechte, und ich schaltete auf stur. Immerhin weiß ich heute endlich, dass Mutter zumindest in dieser Sache Recht hatte.

Gedankenversunken ging ich nach Haus. Warum hat mir das noch kein Arzt gesagt? Warum weiß das keiner meiner Freunde? Die Erklärung des Arztes war so einfach wie einleuchtend. Und war ich nicht bestimmt schon hundert Mal in meinem Leben erkältet gewesen? Eigentlich war ich Erkältungsprofi. Trotzdem hatte ich Wissen in meinem Kopf, das nicht nur falsch, sondern sogar schädlich war. Vermutlich war dies deshalb so, weil ich in meinem Privatleben nicht derart strukturiert und professionell Wissen aufbaue, wie ich es in meinem Beruf mache. Im Job lief das alles besser, oder nicht?

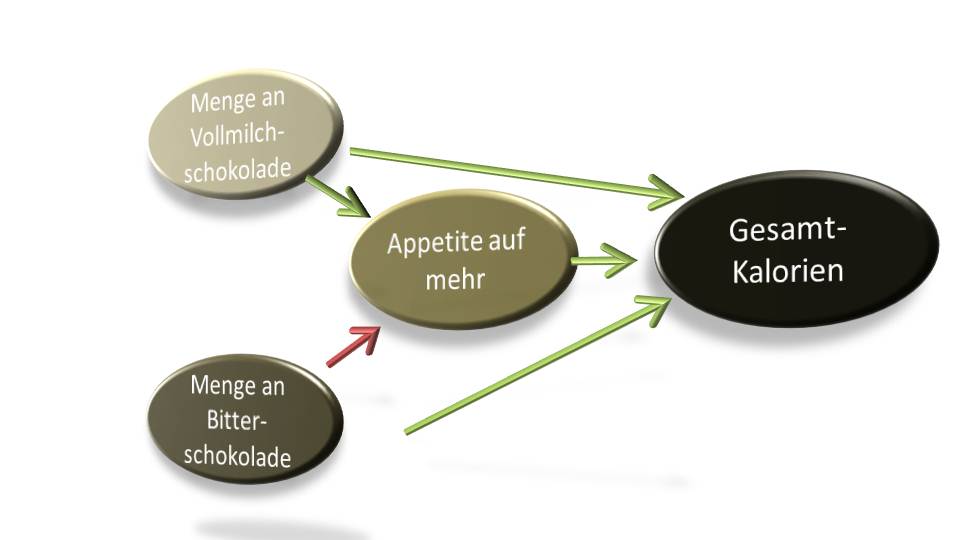

Abends erzählte ich meiner Frau Viktoria von meinen neuen Erkenntnissen. Sie nahm meine Erörterungen nicht unkritisch entgegen, pflichtete mir dann aber bei. Ihr Talent, mir Recht zu geben, ist einer der Gründe, warum ich sie so liebe. Nach meinem Vortrag wollte sie sich entspannen und fragte mich: „Hast du noch was von dieser Bitterschokolade übrig? Die macht ja nicht dick.“

Der kleine Besserwisser in mir erinnerte sie an das Wein-Schokoladen-Seminar, das wir vor kurzem gemeinsam absolviert hatten. Dort machte uns der Kursleiter darauf aufmerksam, dass Bitterschokolade, bedingt durch den höheren Kakaofettanteil, die gleichen Kalorien hat wie ihr Pendant aus Vollmilch. Bitterschokolade hat viel Fett und Vollmilchschokolade hat viel Zucker. Warum also sollte Bitterschokolade nicht so dick machen?

Ich kann nur mutmaßen. Vermutlich neigen Vollmilch-Fans dazu, Unmengen davon zu verzehren, während Bitterschokoladen-Liebhaber tendenziell sparsamer mit dem Genussmittel umgehen. Ob dies an der Schokolade liegt oder ob andere Variablen dafür verantwortlich zeichnen, vermag ich nicht zu beurteilen. Fakt ist, dass jeder „weiß“, dass Vollmilchschokolade dick macht. In Wahrheit aber macht nur viel essen dick, und wenig essen hält schlank.

Zum Glück finden derlei Verwirrungen nur in so unwichtigen Bereichen wie der Schokoladenwahl statt. Meine Frau allerdings wäre geschockt. Denn zu verwechseln, was dick oder schlank macht, ist nicht unwichtig für eine Frau. Okay, wir sind halt auch keine Profis.

Die wachsende Liste der Alltagsmythen, denen wir zum Opfer fallen, hat mich aufmerksam gemacht. So stieß ich vor kurzem auf einen weiteren Mythos.

Ich selbst bin im grauen Osten Deutschlands groß geworden – in einer Zeit, in der Kinderlachen eine Seltenheit war, da es noch keine D-Mark gab. Bei uns war es üblich, dass wir am Wochenende badeten. Keine Ahnung warum, Wasser gab es genug. Ich wusch mir einmal die Woche die Haare. Den Fotos zufolge sahen diese keineswegs fettig aus.

Heute lerne ich aus der Fernsehwerbung, dass tägliches Haarewaschen gar kein Problem ist. Und im Bekanntenkreis gilt man als Sonderling, wenn man zugibt, dies nur alle zwei Tage zu tun. Ein Normalo war ich noch nie. Daher scheue ich mich nicht, ganz offen zu sein. Zum Glück kam mir vor ein paar Jahren wieder Galileo zu Hilfe. Dort testete man genau dieses Phänomen. Man ließ ein paar Damen ihre Haare einige Wochen ungewaschen tragen. Die Folge war, dass die Haare weniger nachfetteten. Daher war ein häufiges Waschen auch nicht mehr notwendig. Das Nachfetten des Haares ist eine Schutzfunktion, die das Haar pflegt und langlebiger macht. Je häufiger Sie waschen, desto mehr muss der Körper nachfetten, um den Schutz aufrecht zu erhalten.

Wie sind nur unsere Vorfahren vor 10.000 Jahren ohne L’Oreal-Produkte ausgekommen? Zugegeben, die sahen damals sicher nicht so elegant aus wie meine Frau heute. Dennoch habe ich das Gefühl, dass diese Mode nicht besonders gesund ist. Wer dennoch auf der täglichen Haarwäsche bestehen möchte, dem sei das natürlich zugestanden. Denn frisch gewaschene Haare sehen natürlich immer am besten aus. Die gesundheitlichen Folgen allerdings muss jeder für sich selbst abwägen.

Aber darum soll es hier primär nicht gehen. Erstaunlich ist allerdings, dass es sich als Grundgesetz der Haarpflege in unsere Köpfe gebrannt hat, dass tägliches Waschen absolute Pflicht ist. Dass hier Ursache und Wirkung verwechselt werden, ist uns allen scheinbar nicht klar.

Zum Glück geht es nur um so banale Dinge wie das Haarewaschen. Ginge es um wirtschaftliche Sachverhalte, würden wir spätestens durch eine Befragungsstudie herausfinden, wohin der Hase läuft. Das glauben wir gern. Aber das ist ein trauriger Irrtum.

Wenn Profis nach Ursachen forschen

Wenn Profis auf die Suche nach Ursachen gehen, werden meist Zahlen verglichen. Worin unterscheiden sich Erfolgreiche von Nicht-Erfolgreichen im Hinblick auf diverse Erfolgsparameter? Korreliert die eine oder andere persönliche Eigenschaft mit dem Erfolg einer Person? Gleich zu Anfang dieses Buches möchte ich den größten Zahn ziehen: Diese „Profi-Methoden“ sind größtenteils unbrauchbar und darüber hinaus oft brandgefährlich.

Vergleichen wir einmal die Vornamen von starken und weniger guten Schülern in Chicago. Wir finden höchst signifikante Ergebnisse. Erfolgreiche Mädchen heißen oft „Judy“, weniger erfolgreiche wurden häufig „Britney“ getauft[1]. In Deutschland heißen die Schulversager Justin und die Durchstarter Maximilian. Der Hintergrund dürfte dem geneigten Leser klar sein. Das Phänomen ist unter dem Begriff Scheinkorrelation bekannt.

Ein anderes Beispiel für solche Scheinkorrelationen ist das angeblich sinkende Durchschnittseinkommen deutscher Ärzte, das vor einigen Jahren festgestellt wurde.[2] Diese Zahlen werden von Lobbyisten natürlich nur zu gern in ihrem Sinn kausal interpretiert. Der wahre Hintergrund der Zahlen war jedoch ein anderer. Tatsächlich nämlich stieg das Einkommen der angestammten Ärzte. Dass jedoch deutlich mehr junge Ärzte mit geringerem Verdienst approbiert worden waren, zog den Durchschnitt in den Keller.

Auch das ist nur ein Beispiel, das nichts mit der Realität in Unternehmen zu tun hat? Weit gefehlt! Wir werden noch sehen, dass jedes Controller-Reporting und jede Bilanz randvoll mit diesen Scheineffekten sind. Fakten sagen nichts über Ursachen. Daher ist jeder Satz über eine Bilanz oder einen Report, der eine Aussage mit „weil“ ableitet, höchstwahrscheinlich haltlos.

Vergleichbare Beispiele gibt es zahllose. So steigt das Einstiegseinkommen von Universitätsabsolventen statistisch gesehen mit der Studiendauer[3]. Wie bitte? Ich Dussel habe mich mit dem Studium beeilt und jetzt das. Hätte ich doch lieber das Studentenleben ausgiebig genossen. Stopp! Natürlich hat auch diese Statistik einen Haken. Sie würfelt Apfel und Birnen zusammen. Genauer: Es werden Betriebs-wirtschaftler, Physiker oder Chemiker gemeinsam betrachtet.

Physiker studieren nämlich grundsätzlich länger, und noch länger tun es Chemiker. Dafür sind die Einstiegsgehälter für Chemiker auch erheblich höher als für BWL-Absolventen. Betrachtet man die Korrelation von Einstiegsgehalt und Studiendauer nur innerhalb eines Studienfaches, stimmt die Richtung wieder. Die Schnelleren verdienen mehr.

Gesundheitsstatistiken sind ähnlich trügerisch. Ein Blick auf die Sterblichkeitsrate durch Krebs offenbart: 26 Prozent der Menschen sterben heute durch Krebs. Vor 100 Jahren waren es lediglich zehn Prozent. Warum, wird man sich fragen, steigt die Bedrohung durch Krebs, obwohl die Therapeutik so viele Fortschritte macht? Schon vermuten wir die Übeltäter, wo sie nicht sind. Schuld tragen bestimmt die Luftverschmutzung, die Nahrungsergänzungsmittel oder die Atomkraftwerke. All das mag in gewisser Weise seinen Teil zur Krebsrate beitragen, ohne dass wir es sicher wissen. Der wahre Grund ist allerdings viel trivialer. Menschen werden immer älter. Krebs hingegen ist auch einfach eine Alterserscheinung. Die Chance, mit einem Krebsbefund konfrontiert zu werden, ist im vergleichbaren Alter heute vermutlich geringer als früher, und die Chance, ein Karzinom zu überleben, ist so hoch wie nie[4]. Fakten sind nur Fakten und verraten für sich allein betrachtet erst einmal absolut nichts über ihre Hintergründe.

Um beim Thema zu bleiben: Intensive Studien haben gezeigt, dass lange Chemotherapien mit höherer Sterblichkeit der Patienten einhergehen. Aufgrund dieser Zahlen haben sich sogar einige „Wissenschaftler“ dazu hinreißen lassen, eine geringe Dauer der Chemobehandlungen vorzuschreiben. Schaut man allerdings etwas tiefer, wird schnell klar, wie viele Menschenleben eine solche Empfehlung kosten kann.[5] Aus medizinischen Gründen und zum Schutz des Patienten ist bei der Anwendung chemischer Methoden eine Maximaldosis vorgegeben. Deshalb muss man bei besonders schwerwiegenden Fällen einfach eine längere Therapie durchführen. Die höhere Sterblichkeit ergibt sich hier nicht aus der Behandlungsdauer, sondern aus der Größe des Tumors zu Beginn der Chemo. Bei aller Bedeutung verbesserter Tumorbehandlung bedeutet ein zu großer Tumor eben fast immer auch ein Todesurteil. Therapien wirken hier eher lebensverlängernd als lebensrettend. Aus diesem Grund ist es klüger, mehr in die Früherkennung zu investieren.

Zum Thema Umweltgifte gibt es eine weitere spannende Studie aus Schweden. Aus der Untersuchung folgte, dass Familien mit PVC-Fußböden in hoch signifikanter Weise mehr Kinder mit Asthma haben. Bevor PVC-Fußböden vollends verboten wurden, fanden kritische Praktiker heraus, dass viele Eltern PVC-Fußböden verlegen ließen, WEIL ihre Kinder Asthma hatten.[6] So konnte der anfallende Staub besser beseitigt werden.

Fakten sagen eben nichts über das Warum. Vor allem dann nicht, wenn die Zeit ihre Finger im Spiel hat. Die Ursache passiert immer vor der Folge. Daher lohnt es sich stets, die zeitliche Abfolge im Blick zu behalten. Ein schönes Beispiel, wie uns die Korrelation von Zeitreihen ein Schnippchen schlagen kann, hat Steven D. Levitt in seinem Bestseller „Freakonomics“ beschrieben.

Anfang der 90er-Jahre war die Kriminalitätsrate in den USA enorm hoch. Vermutlich ein Grund, warum ein Vertreter von Law and Order wie Rudolph Giuliani zum neuen Bürgermeister von New York gewählt wurde. Schon nach kürzester Zeit schien seine drastische Restrukturierung des Polizeiapparates Wirkung zu zeigen. Die Kriminalität sank drastisch, Giuliani wurde weltweit gefeiert. Kann man sich einen besseren Beweis für die Wirksamkeit von hartem Durchgreifen wünschen?

Die Antwort ist: Ja. Zeitreihen wie die Kriminalitätsrate oder die politische Ausrichtung von Regierungen haben Trends. Sie gehen entweder noch oben oder nach unten. Fasst man die betrachteten Zeitintervalle ausreichend kurz, kann man nach Belieben Zusammenhänge hineininterpretieren. So sank in den letzten Jahren auch die menschliche Geburtenrate parallel zur Storchenpopulation in Deutschland. Was sagt uns das? Bringt der Storch doch die Kinder?

In Freakonomics wird anschaulich geschildert, dass der Hintergrund des Kriminalitätsrückgangs, der im Übrigen in den ganzen USA zu verzeichnen war, vorwiegend auf die Legalisierung des Schwangerschaftsabbruchs im Jahre 1973 zurückzuführen ist. Junge, werdende Mütter der Unterschicht, die oftmals alleinstehend waren, konnten nun entscheiden, das Kind nicht auszutragen. Somit wurden deutlich weniger unterprivilegierte Kinder geboren, die durch ihr Umfeld einer höheren Wahrscheinlichkeit unterlagen, später kriminell zu werden. Dieser Effekt machte sich schließlich bemerkbar, als die Schicht der jungen kriminellen Erwachsenen Anfang der neunziger Jahre wegbrach. Giuliani hatte einfach Glück, zur rechten Zeit im Amt zu sein und hat den Abwärtstrend der Kriminalitätsrate zu seinem Verdienst uminterpretiert. So macht man Karriere!

Aber in der Wirtschaft kann so was zum Glück nicht passieren. Keine gestandene Führungskraft lässt sich von einfachem Gleichlauf von Zeitreihen beeindrucken. Oder doch?

[1]Levitt et al. „Freakonomics“

[2]Krämer in „So lügt man mit Zahlen“, S.171

[3]Krämer in „So lügt man mit Zahlen“, S.171f

[4]Krämer in „So lügt man mit Zahlen“, S.171f

[5]Bosbach et al in „Lügen mit Zahlen“, S. 57f

[6]Bosbach et al in „Lügen mit Zahlen“, S. 55f

KAPITEL 2

Eine Management-Illusion

Die zuvor beschriebenen Alltagsmythen beweisen unsere relative Unfähigkeit, die Ursachen von Zielgrößen zu erkennen, die mehr als eine Ursache haben, die also von mehr als einem Faktor beeinflusst werden. So, wie der Orangensaft über verschlungene Pfade unser Abwehrsystem beeinflusst oder so, wie nasse Haare keineswegs direkt eine Erkältung auslösen. Ebenso wenig macht auch Bitterschokolade weniger dick.

Solche Hypothesen über Ursachen stellen wir auf, wenn zwei Größen zusammen auftreten oder deren Ausprägungen in die gleiche Richtung zeigen. Wenn also eine Maßnahme mit dem Steigen einer anderen Größe einhergeht, so nehmen wir intuitiv Kausalität an. Dies ist exakt die Methode, nach der ein Hund in Pavlows Experiment lernt, dass die Glocke das „Essen bringt“, weshalb der Speichelfluss schon mal auf Volltouren gebracht werden muss. Wie wir jedoch gesehen haben, führt diese Forschungsmethode regelmäßig in die Irre.

Doch was bedeutet das für das Management von Unternehmen? Existieren ähnliche Mythen auch im Managementwissen oder in großen Teilbereichen der Betriebswirtschaftslehre? Wird Wissen dort ebenso laienhaft aufgebaut, wie es in unserer Freizeit geschieht? Das wäre fatal. Esse ich ein bisschen zu viel Zartbitterschokolade, nehme ich ein paar Gramm zu – stecke ich viel Geld in eine falsche Investition, kann das schlimmstenfalls in die Insolvenz führen.

Um diese Frage zu erhellen, möchte ich aus meiner eigenen Erfahrung als Manager und Unternehmensberater berichten. Urteilen Sie selbst, ob Ihnen das eine oder andere bekannt vorkommt.

Als Berater war ich in einem weitreichenden Projekt einer großen deutschen Regionalbank engagiert. Definiertes Ziel der Maßnahme war es, aus Kundendaten Erkenntnisse zu gewinnen, um daraus Strategien zum Churn-Management, also zur Kundenbindung, und zur Steigerung des Cross-Selling abzuleiten. Als „bewährtes“ Vorgehen für das Identifizieren von Cross-Selling-Potenzialen galt bislang, Kunden

mit gut gefülltem Konto auf Kredite anzusprechen. Man hatte eine starke Korrelation zwischen hohem Kontostand und der Wahrscheinlichkeit, auf Kredit zu kaufen, festgestellt. Deshalb bot man dieser Gruppe verstärkt Privatkredite an.

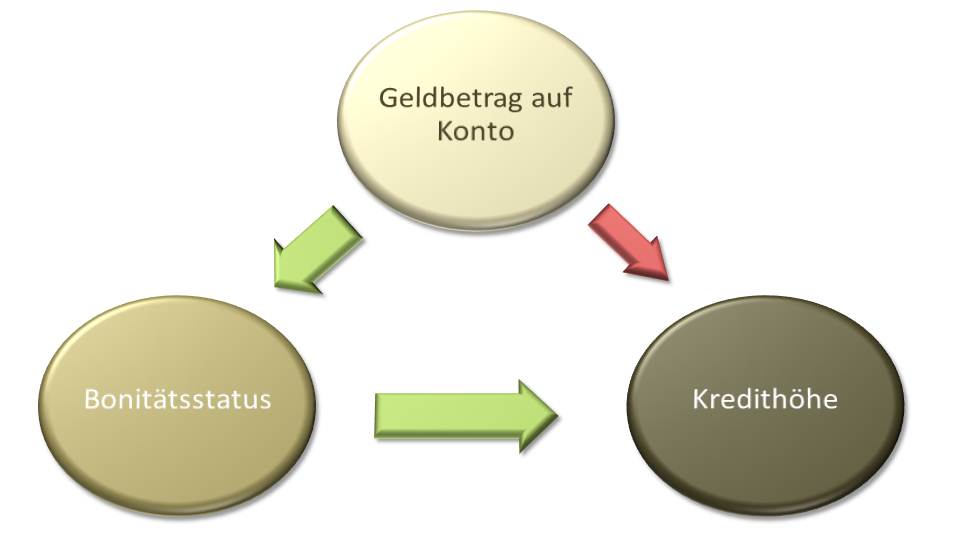

Eine Treiberanalyse mit multivariaten Analyseverfahren[1] ergab jedoch eine Überraschung. Die Untersuchungen zeigten, dass der Kontostand einen negativen (!) Einfluss auf die Kreditwahrscheinlichkeit hatte. Wir waren verwundert. Können wir der Methode trauen? Eine intensivere Betrachtung der Ergebnisse machte klar, dass insbesondere der Bonitätsstatus eines Kunden positiven Einfluss auf seine Kreditaufnahmen hatte. Da machte es bei uns Klick. Klar, Kredite bekommen Leute mit hoher Bonität. Diese Solvenz bekomme ich, wenn ich vermögend bin. Gleichzeitig brauche ich jedoch tendenziell keinen Kredit, wenn ich genügend liquide Mittel besitze. Wir konnten also zeigen, dass die bisherige Targeting-Methode nicht nur ineffektiv, sondern sogar kontraproduktiv war.

Später, als Sales & Marketing Manager eines Industrieunternehmens, liefen mir weitere dieser Mythen über den Weg. Ich war erst ein paar Wochen an Bord und bekam immer wieder zu hören: „Unsere Kunden im Pharmabereich zahlen für unsere Produkte hohe Preise. Da müssen wir mehr machen und expandieren.“ Ein kritisches Studium der reichlich vorhandenen Transaktionsdaten brachte mich zu einer anderen Hypothese. Ich konnte nachweisen, dass Pharmakunden eher kleine bis mittlere Abnahmemengen aufwiesen. Im Vergleich zu anderen Kunden im Chemiebereich mit gleichen Abnahmen war plötzlich kein Preisunterschied mehr feststellbar. Die Kollegen waren einer klassischen Scheinkorrelation aufgesessen. Das Preisniveau hatte nichts mit der Branche zu tun, sondern war lediglich davon beeinflusst, dass die Abnahmemengen in diesem Bereich klein und die Mengenrabatte spärlich waren. In der Folge konnten unsinnige Investitionen verhindert werden.

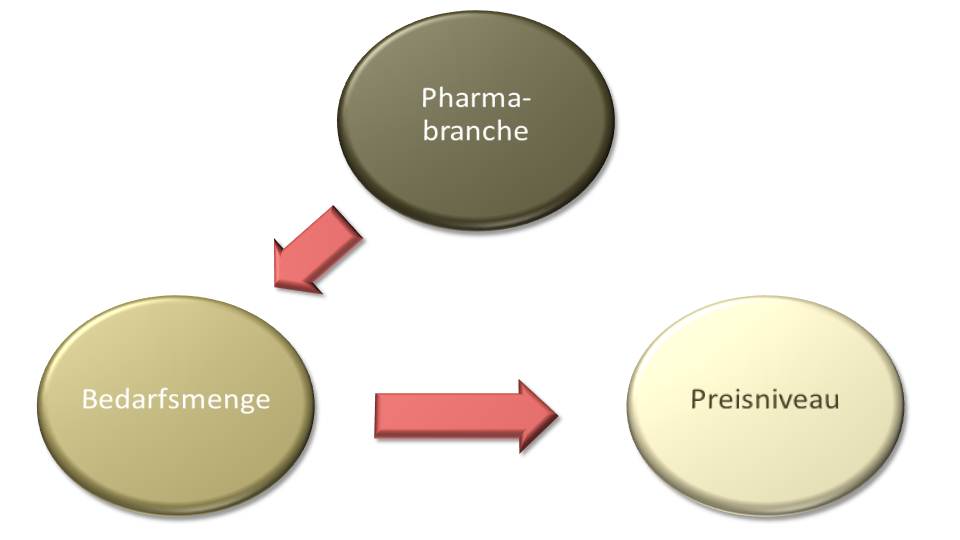

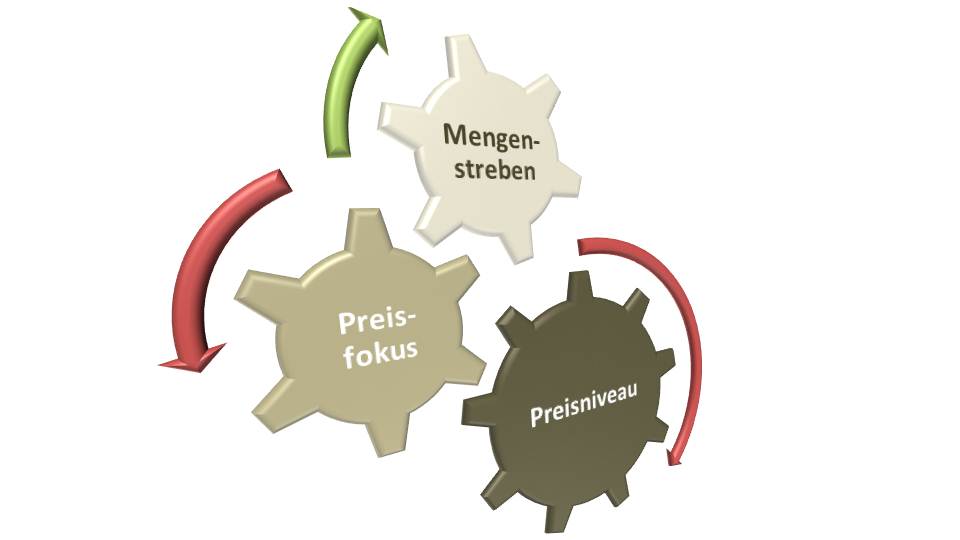

Was passieren kann, wenn auf Ursachenanalysen verzichtet wird, konnte ich einige Jahre später am Marktverhalten unseres Wettbewerbers feststellen. Dieser hatte sein gesamtes Vertriebsteam ausgewechselt und nur noch begrenztes Know-how darüber, wie die Märkte funktionieren. Vermutlich machten die Kollegen auch Datenanalysen und hatten festgestellt, dass der Markt für Pappfässer hervorragende Margen aufwies. Die fatale Schlussfolgerung der Kollegen klang verlockend: „Wir müssen in diesem Markt mehr machen – da kann man Geld verdienen.“ Gesagt, getan. Es wurden niedrigere Preise gemacht, um Neukunden gewinnen zu können. Denn wer über keinen herausragenden Wettbewerbsvorteil verfügt, hat nur den Preis als Stellschraube, um Marktanteile zu erobern. Erwartungsgemäß zogen die Verkäufe deutlich an. Die Reaktion der Wettbewerber ließ jedoch nicht lange auf sich warten. Nach dieser Preisbereinigung gingen die Marktanteile auf das frühere Niveau zurück, aber das Preisniveau am Markt war zerstört. Der Markt für Pappfässer war nicht deshalb profitabel gewesen, weil Kunden bereit waren, mehr dafür zu zahlen, sondern weil die Wettbewerber aufgrund von Markthistorie und Anbieterkonzentration darauf verzichten konnten, allzu preisaggressiv aufzutreten.

Dieses und alle anderen Beispiele zeigen drastisch, dass Fakten allein keine nutzbringende Information darüber enthalten, wie sie zustande kommen. Was allein zählt, ist das Wissen über Ursache-Wirkungs-Zusammenhänge. Voraussetzung für dieses Wissen ist das Verständnis des Beziehungsnetzwerks im untersuchten Bereich. Nur so werden richtige und gute Entscheidungen möglich.

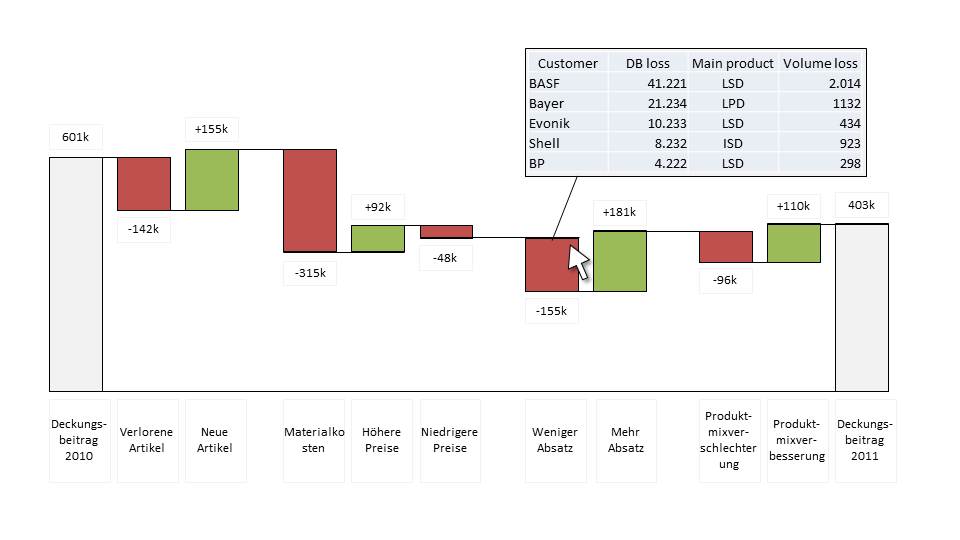

Später wurde ich am gleichen Ort mit dem Performance-Management des Vertriebs betraut. Im Kern bestand die Aufgabe darin, im Dialog mit dem Vertrieb diverse Kennzahlen zu prüfen und in einer gemeinsamen Aktion Verbesserungspotenziale aufzudecken und zu tracken. Wie in großen Unternehmen üblich, kamen regelmäßig auch von oberen Hierarchieebenen Anfragen wie: „Was ist im Bereich Garagenfass los? Die Gewinnmarge ist in diesem Monat eingebrochen. Ich brauche bis morgen eine Aufstellung, wo wir sofort Preise erhöhen können.“ Für die Ursachenklärung dieser Sachverhalte war es oft notwendig, die Transaktionsdaten bis auf den einzelnen Artikel und die einzelne Bestellung herunterzubrechen. Warum? Weil eine Kennzahl, wie die aggregierte Gewinnmarge einer Produktgruppe, so etwas ist, wie das scheinbar hohe Einstiegsgehalt von Langzeitstudenten. Man geht fast immer Scheinkorrelationen auf den Leim.

Beispiel: Der Deckungsbeitrag war irgendwann eingebrochen, weil ein Großkunde, der sehr niedrige Preise genoss, seine kompletten Bestellungen vom letzten Monat auf den folgenden Monat verschoben hatte. So wurde der Vormonat optisch besser, der aktuelle Monat schlechter und die Differenz sah ganz besonders übel aus. Derlei Beispiele gibt es viele. Sie zeigen, wie gefährlich es ist, auf Basis von Kennzahlen (neudeutsch KPIs) Entscheidungen zu treffen. Das Kapitel „Umsetzen“ wird zeigen, wie man Kennzahlen aufbauen sollte, um eine große Menge von Scheinkorrelationen zu vermeiden.

Kennzahlen sind nur Fakten und haben für sich genommen keinen Informationswert. Das Warum ist von zentraler Bedeutung. Die ganze Ideologie des Fact-based-Management wird vor diesem Hintergrund in Frage gestellt. Nicht Fakten sollten im Vordergrund stehen, sondern das Wissen über Ursache-Wirkungs-Zusammenhänge. Was wir demnach dringend benötigen, ist ein Knowledge-based-Management.

Doch was bedeutet das für Controlling, Reporting und Performance-Management, die mit all diesen schicken Dashboards sorgfältig in unseren Unternehmen aufgesetzt wurden? Welche Konsequenzen hat es für unsere Organisation und die Mitarbeiter? Mitarbeiter wissen meist intuitiv, dass die Kennzahlen „was für die da oben“ sind, aber wenig mit der Realität zu tun haben. Aber Steuern mit Kennzahlen schafft auch Realität. Wenn der Chef sagt, der Deckungsbetrag muss hoch, dann wird gehandelt – koste es, was es wolle. Wenn der ROI steigen soll, schließt man einfach alle Geschäfte, die unterdurchschnittlich sind, auch wenn sie die Kapitalkosten decken und gutes Geld verdient wird. Zum Trimmen von Kennzahlen gibt es so viele Wege wie Ursachen. Nur diese Wege sind oft nicht im Sinne des Unternehmens.

Das alternative „Beyond Budgeting“ etwa setzt, statt Kennzahlen zu verabsolutieren, Werte in Relation zu externen Vergleichswerten. Der Gedanke ist gut, hat jedoch erhebliche Grenzen. Gerne möchte man externe Faktoren aus Kennzahlen herausrechnen. So betrachtet man etwa statt dem Gewinn den relativen Gewinn im Vergleich zum Wettbewerb. Ein Problem dabei ist die Frage, wo man die Vergleichszahlen überhaupt herbekommt. Ist man in der glücklichen Informationslage, dass alle Daten vorliegen, schlittert man ins nächste Problem, wenn man bereits zwei externe Faktoren herausrechnen möchte. Wir werden im nächsten Kapitel sehen, wie man besser vorgehen sollte.

Wir stellen fest, dass das Ableiten von Maßnahmen auf Basis üblicher Kennzahlen ein erhebliches Fehlverhalten verursacht. Dass es noch schlimmer geht, zeigt eine kleine Anekdote aus meiner Praxis. Die meisten Führungskräfte, die regelmäßig mit ihren Mitarbeitern die wichtigsten KPIs durchgehen, werden Ähnliches schon erlebt haben: Als ich mir den aktuellen durchschnittlichen Rohertrag (Preis minus Materialkosten) ansah, fiel mir auf, dass dieser gesunken war. Natürlich fragte ich den den verantwortlichen Außendienstmann: „Was war da los diesen Monat?“ Seine Antwort: „Oh ja, die neuen Preise für Großkunde Fa. Müller gelten erst ab nächsten Monat. Und die hochprofitablen ABC-Produkte wurden diesen Monat wegen fehlendem Bedarf nicht bestellt.“ Eine ziemlich schlüssige Begründung. Ich bin zufrieden. Plötzlich fällt mir auf, dass ich den falschen Zeitraum eingestellt hatte und mir die Zahlen vom letzten Jahr angesehen hatte. Verglichen damit sinken sie Zahlen gar nicht, sondern sie steigen! „Äh sorry, mein Fehler. Warum steigt denn der Rohertrag?“ Daraufhin der Mitarbeiter: „Ja richtig, ich hab ja den neuen Kunden Fa. Meier an Land geholt und die restlichen Preiserhöhungen konnte ich gut durchdrücken.“

Was sagt uns das? Beobachten Sie einfach mal, wie Manager auf Fakten reagieren. Werden beliebige Zahlen oder andere Fakten präsentiert, so wird sofort eine Legende darüber gesponnen, wie diese Zahlen zustande gekommen sind. Es ist wie ein Reflex. Ich kann selbst nicht anders. Nur dass fast alle tatsächlich daran glauben, dass ihre aus den Fingern gesaugten Mutmaßungen mit hoher Wahrscheinlichkeit richtig sind. Es ist frappierend. Wir finden immer eine Begründung für eine Zahl oder einen Fakt – leider immer erst hinterher. Vorher weiß es keiner. Die Finanzkrise 2008 hat kaum

jemand kommen sehen – vor allem nicht die Medien. Im Nachhinein findet die Presse schnell die Schuldigen. Wenn es so offensichtlich war, warum hat denn keiner dieser Schreiberlinge vorher davor gewarnt? Das ist alles nur haltloses Storytelling im Nachhinein. Es enthält keinerlei nützliches Wissen. Daher ist es auch gefährlich, sich zu sehr mit diesem „Rauschen“ (wie Nachrichtentechniker sagen) zu beschäftigen. Es führt geradewegs zum Kaffeesatzlesen und zu zwar verfestigtem aber falschem Wissen.[2]

Die Welt des Managements ist übervoll von diesen haltlosen Legenden. 80 Prozent der Bücher in der Managementliteratur funktionieren wie folgt: Zig Fallbeispiele aus erfolgreichen Unternehmen werden werden daraufhin interpretiert, warum sie erfolgreich waren. Dieses Vorgehen ist ein gelungener Mix aus clever selektierten Beispielen und der geschickten Unterschlagung gegenläufiger Fälle – garniert mit einem höchst phantasievollen Storytelling über die Scheinursachen. Meinen persönlichen Aha-Effekt hatte ich, noch bevor ich beschlossen hatte, allen Fehlinformationen durch Managementbücher abzuschwören. Zuerst las ich Wachsen ohne Wachstumsmärkte von Adrian Slywotzky und Andrew Wise, in dem wunderbar beschrieben ist, wie wertvoll es sein kann, sich durch Vorwärtsintegration in die Prozesse des Kunden einzugraben. Als eines ihrer Paradebeispiele fungierte die Firma Cardinal Health – ein riesiger Pharmagroßhändler mit 80 Milliarden Umsatz, der sich durch diverse Produkte und Services tiefer in die Prozesse von Krankenhäusern und Apotheken eingrub. Stolz wandte ich mein neu „erlesenes“ Wissen in einem internen Strategieworkshop an, indem ich mich auf Cardinal Health bezog. Ein Kollege konterte: „Moment! Soweit ich weiß, geht es Cardinal Health derzeit gar nicht gut. Die haben zu viele Geschäftsfelder jenseits ihrer Kernkompetenzen adressiert. Das alles kannst du prima in Chris Zooks Beyond the Core nachlesen. Bei Zook ist Cardinal Health als drastisches Negativbeispiel genannt.“

Beispiele sind schöne Illustrationen, um Konzepte verständlich zu machen. Als Indiz oder gar Beweis für Theorien über Ursachen taugen sie allerdings keinesfalls. Warum das so ist? Weil die meisten Tatsachen mehr als ein oder zwei Einflussgrößen haben. Weil das so ist, scheitern wir immer dabei, durch Vergleiche von lediglich zwei

Größen korrekte Schlüsse über Ursache-Wirkungs-Zusammenhänge zu ziehen.

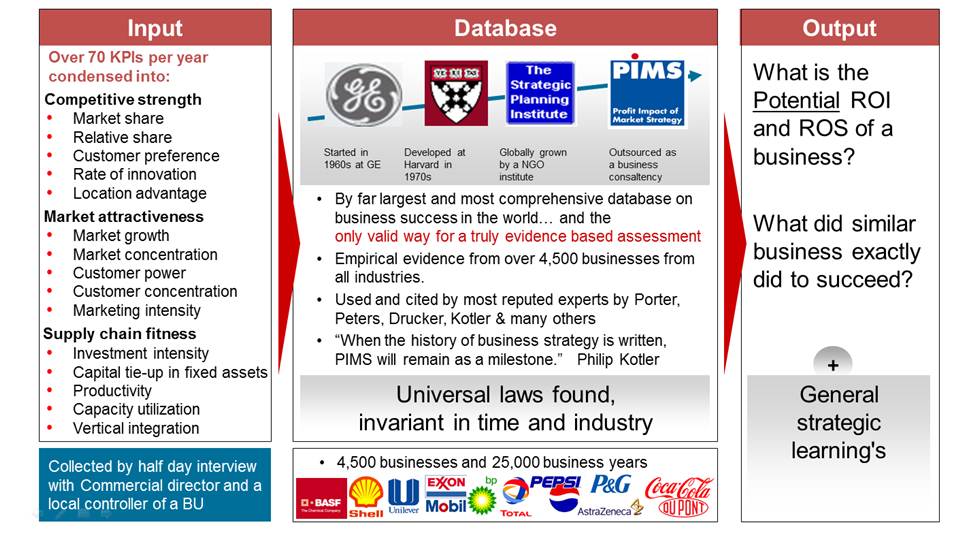

Andere Beispiele für Pseudowissen im Management gibt es zur Genüge. Das PIMS-Projekt hat viele davon aufdecken können. PIMS ist eine Datenbank, in der seit den 1970ern über 70 relevante Ursachen für das Return-On-Investment (ROI) einer Unternehmenseinheit gesammelt werden. Es ist vermutlich die einzige Datenbank, mit der ein ursächlicher Einfluss von Marktstrategien auf die Unternehmens-profitabilität wissenschaftlich valide untersucht werden kann.

Das typische Vorgehen in den Strategiestäben der Unternehmen ist ungefähr wie folgt: „Lasst uns anschauen, welche Märkte am meisten wachsen (Megatrends), welche Märkte groß sind und wo man gutes Geld verdienen kann (Marge).“ PIMS hat gezeigt, dass dieses hochplausible Vorgehen nicht nur irrelevant, sondern teilweise sogar gefährlich ist. Denn, weil es so intuitiv einsichtig scheint, handelt fast jeder Marktteilnehmer so. In Wahrheit ist es immer eine schlechte Idee, neu in einen zu großen Markt einzusteigen, da man selbst nicht schnell genug kritische Masse erreichen kann. Märkte, die klein genug sind, um darin Marktführer zu werden, sind erheblich attraktiver.

Weiterhin ist es absolut irrelevant, sich am heutigen ROI zu orientieren. Was einzig und allein zählt, ist der potenzielle ROI. Profitable Geschäfte sind nun mal auch teuer zu erwerben. In anderen Fällen zerstört man durch die hohe Investition in eigene Kapazitäten womöglich den Grund für die Profitabilität in einem Geschäftsfeld (wie in unserem Pappfässer-Beispiel). Nicht zuletzt ist auch die aktuelle Marge, der EBIT, so gut wie irrelevant (zumindest sofern er positiv ist). Denn was zählt, ist das Verhältnis im ROI, also das vom gebundenen Kapital zum Gewinn. PC-Direkthändler, wie etwa DELL, verdienen ihr Geld nicht mit hoher Marge, sondern damit, dass kein Kapital im Geschäft gebunden ist, weil die Kunden alles vorschießen. Der Kunde zahlt zuerst, und erst dann werden Einzelteile eingekauft, PCs zusammengesteckt und ausgeliefert. Aldi hat vermutlich auch deshalb einen sehr hohen ROI, weil, verursacht durch die geringe Produktvielfalt, Artikel nur wenige Tage im Regal liegen bleiben.

Ein anderer Mythos, mit dem PIMS aufgeräumt hat, ist die von Michael E. Porter

aufgebrachte Verallgemeinerung, dass die Kundenmacht möglichst klein sein sollte. PIMS hat das relativiert und einen U-förmigen Zusammenhang nachgewiesen. Wenn die Kundenanzahl eines Unternehmens einstellig wird, beginnt der Zusammenhang sich umzukehren. Denn in vielen Fällen hat die Abhängigkeit dann einen Hintergrund – sie ist symmetrisch. Beide Partner brauchen sich. Der Lieferant liefert besondere Leistungen, der Kunde gibt durch einen guten Preis einen Teil der Wertschöpfung ab.

Diese Beispiele illustrieren folgende Punkte:

- Die deskriptive Analyse von Fakten führt oft zu falschen Erkenntnissen.

- Menschen neigen dazu, Ursachen auf Basis von Fakten buchstäblich zu erfinden und durch Storytelling plausibel zu machen.

- Mythen entstehen als natürliche Folge von falschen Analysen und der Weitergabe dieses willkürlich entwickelten Pseudowissens. Es kann nachgewiesen werden, dass ein Großteil des verbreiteten Management-wissens schlichtweg falsch ist. Was nicht gänzlich falsch ist, ist teilweise so vage, dass es nicht widerlegbar (im Sinne der Wissenschaftstheorie inhaltsleer) und daher unbrauchbar ist.

In den 80er Jahren erwuchs aus der sehr nützlichen Systemorientierten (Kybernetischen) Managementlehre unter anderem die Forderung nach komplexerem und besser vernetztem Denken. Der Hintergrund war die Feststellung, dass Zielgrößen im Management viele Ursachen und Treiber haben und gegenseitig vernetzt sind, weil indirekte Wirkeffekte und Rückkopplungen existieren. Fest steht, dass ein adäquateres, elaborierteres Denken sicher nicht schaden kann. Dieses Buch soll zusätzlich zeigen, dass elaborierteres Denken nicht ausreicht, um Komplexität zu managen. Es kommt primär darauf an, richtiges und gesichertes Wissen zu bilden. Hierfür benötigen wir Menschen geeignete Werkzeuge.

Dieterich Dörner hat in diesem Zusammenhang untersucht, wie Menschen komplexe Systeme managen können. Er baute einfache mathematische Modelle über die ökonomischen Zusammenhänge in einem Land auf und bat Probanden, dieses Land im Rahmen eines Planspiels zu managen und den Wohlstand zu mehren. Dabei kannten die Probanden die tatsächlichen Ursache-Wirkungs-Beziehungen nicht. Im Ergebnis stellte Dörner fest, dass wir Menschen erhebliche Probleme haben, komplexe Systeme zu managen. Selbst gute Probanden erlernten dieses Management erst nach vielen Spieljahren, indem sie zunehmend systemischer dachten und Zeitverzögerungen einkalkulierten.

Was lernen wir daraus? Zwar ist vernetztes Denken nützlich, jedoch haben Manager keine fünfzig Jahre Zeit, alle Ursache-Wirkungs-Beziehungen zu verstehen und zu verinnerlichen. Daher ist es in vielen Fällen überhaupt nicht möglich, durch simple Managementerfahrung erfolgreiches Wissen aufzubauen. Darüber hinaus ist die Realität weit komplexer als diese einfachen Planspiele.

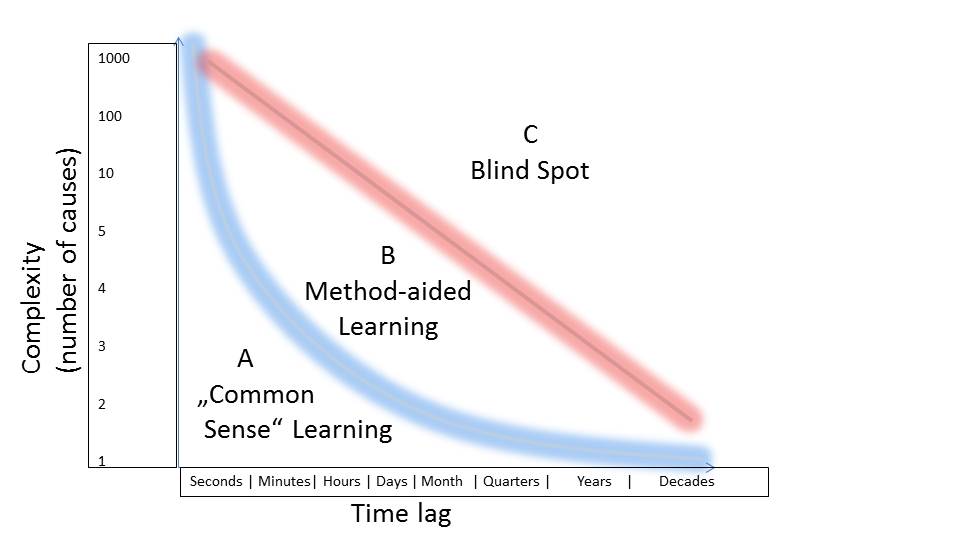

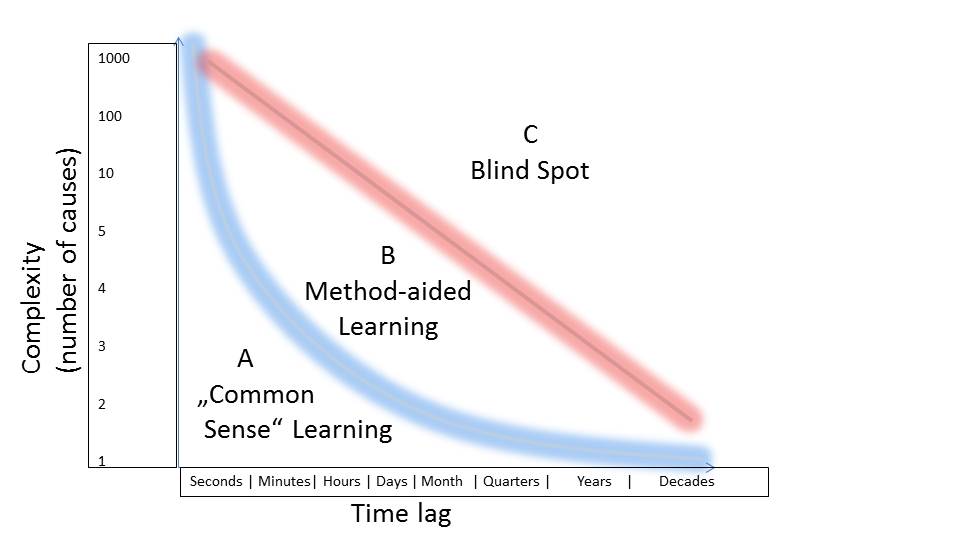

Kurzum, es gibt erhebliche Grenzen, valides Wissen über komplexe Systeme abzuleiten – insofern man keine geeigneten Werkzeuge zur Verfügung hat. Um dies plastisch zu machen, möchte ich hier die Komplexitätsmatrix einführen.

Dimension 1 ist die „Anzahl der beeinflussenden Größen“: Je mehr Dinge auf die zu steuernde Größe zur gleichen Zeit Einfluss nehmen, desto schwieriger ist es, auf Basis von Erfahrungswerten Wissen abzuleiten.

Dimension 2 ist die „Zeit“ die zwischen Ursache und Wirkung vergeht. Je länger man warten muss, bis ein Ergebnis sich einstellt, desto eher wird man durch Folgen anderer Ursachen abgelenkt und desto länger braucht es, bis Wissen aufgebaut ist.

Einfache Probleme mit schneller Rückmeldung können wir durch normales menschliches Lernen gut bewältigen. Beim Autofahren beispielsweise bekommen wir direkte schnelle Rückmeldung und die Treibergrößen sind mit Gas, Bremse und Lenkrad schnell beschrieben.

Nehmen wir ein Problem, bei dem man schnell Rückmeldung bekommt, bei dem aber mehr Größen vorhanden sind: „Wie wirkt ein Plakat?“ Hier zeigt man es potenziellen Kunden und nimmt deren Rückmeldung auf.[3] Jetzt kann ich Teile des Plakats ändern und überprüfen, was das verursacht. Sicher gibt es viele Ursachen, die ein Plakat wirkungsvoll machen. Das geht von der Bildgestaltung und den verbundenen diversen Assoziationen über die Anordnung hin zur inhaltlichen Ausrichtung, Typographie und zur Verwendung von emotionalisierenden Kern-Visuals. Daher ist das Thema sicher hochkomplex. Wenn ich jedoch einige Faktoren fixiere und so die Komplexität reduziere, kann ich durch ein gutes Experimentaldesign herausbekommen, welche Treiber welchen Einfluss haben.

Probleme mit langer Feedbackzeit sind problematischer. Wie lange braucht es, bis ein Produktlaunch seinen Erfolg zeigt? Je nach Industriezweig kann das viele Monate in Anspruch nehmen. Der Erfolg hingegen hat viele, sehr viele Väter. Wenn man die Treiber mit Experimenten erforschen möchte, kann man nicht nur viele Jahrzehnte verbringen, sondern auch Unmengen an Geld verschleudern. Hier wird man vermutlich andere Methoden verwenden müssen, um die Erfolgstreiber besser zu verstehen. Als Daumenregel gilt: Je mehr Ursachen eine Zielgröße hat und je länger es dauert, bis sich Erfolge einstellen, desto eher müssen wir externe Werkzeuge verwenden, um das Problem aktiv managen zu können. Zusätzlich gibt es natürlich auch Grenzen unserer Erkenntnisfähigkeit. Hochkomplexe Systeme mit langer Rückmeldezeit werden wir eventuell nie verstehen. Zumindest wird das so lange gelten, wir keinen Weg finden, das komplexe Problem in einfachere Teilprobleme zu unterteilen.

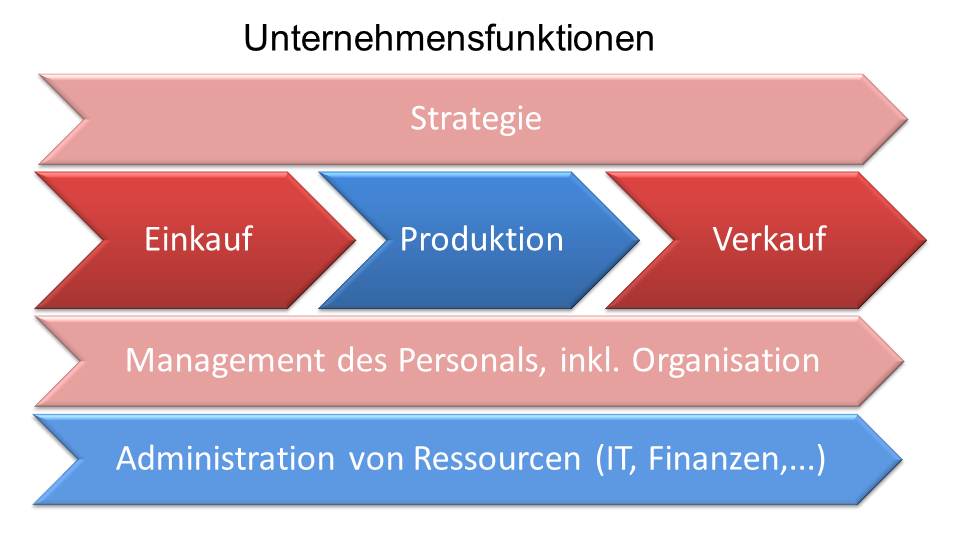

Lassen Sie uns Unternehmensfunktionen einmal entlang der Dimensionen bewerten:

- Mittlere Variablenanzahl und kleines Timelag: Produktion, IT, Verwaltung

- Viele Variablen und größeres Timelag: Einkauf, Verkauf, Marketing, HR/Personalführung, Unternehmensführung

Unternehmensbereiche, deren Aufgabe es ist, die Interaktion mit sozialen Systemen zu managen, seien es die eigene Belegschaft, die Kundenmärkte oder die Lieferantenmärkte, sehen sich einer hohen Komplexität und eher großen Timelags ausgesetzt. In diesen Bereichen haben Zielgrößen viele Ursachen. Beispielsweise können „Steigende Gewinne eines Unternehmens“ tausende Ursachen haben: höhere Preise, profitablerer Produkt-Mix, steigende Verkaufsmengen, sinkende Stück- oder Fixkosten. All diese Bereiche sind eigentlich Aggregate und keine wirklichen Ursachen. Ursachen wäre etwa der Rückzug eines preisaggressiven Wettbewerbers, die Einführung eines überlegenen Neuprodukts oder eine Vertriebsmannschaft, die mehr Kundenbesuche macht. Ursachen sind daher immer Aktivitäten, weniger aggregierte Ergebnisse von Teilgrößen.

Im Gegensatz dazu sind technische Systeme (wie Produktion, IT oder Verwaltungsaufgaben) prinzipiell simpler, weil man sie in Teilsysteme zerlegen kann und diese zumeist sehr schnell Rückmeldung geben. Man bemerkt schnell, ob Maßnahmen die gewünschten Folgen zeigen. Daher kann man schneller und präziser lernen und damit korrektes und funktionierendes Wissen aufbauen.

Die Unternehmensfunktionen Management, Einkauf und Verkauf arbeiten heute tendenziell mit falschem und schlecht gesichertem Wissen. Schuld daran tragen aber nicht die Personen, die dort tätig sind. Diese Bereiche sind komplexer und daher schwieriger zu managen. Das Fatale ist jedoch, dass der Grund für unsere Unfähigkeit, richtiges Wissen zu erlernen, auch gleichzeitig der Grund dafür ist, dass wir dies nicht bemerken. Unser phantasievolles Storytelling findet immer eine plausible (aber haltlose) Theorie darüber, wie sich bestimmte Fakten erklären. Nur scheint dies niemandem aufzufallen. Es entsteht eine Illusion von Kompetenz und eine Illusion, alles im Griff zu haben. Es entsteht die Management-Illusion.

[1]Mehr dazu im nächsten Kapitel

[2]Eins ist mir wichtig: Ich möchte hier niemanden anklagen. Es ist, wie es ist, weil unser Ausbildungssystem so ist, wie es ist. Trotzdem sollten wir natürlich an den offensichtlichen Verbesserungsfeldern arbeiten.

[3]Auf die Beschreibung diverser Marktforschungstechniken zur validen Messung gehe ich hier nicht ein.

KAPITEL 3

Mit richtigen Methoden Ursachen aufspüren

Bislang haben wir eine Bestandsaufnahme gemacht. Die Fähigkeit von Menschen, aus Erfahrungen Wissen abzuleiten, beschränkt sich im Grunde auf die Prinzipien der Konditionierung. Parallel auftretende Sachverhalte werden assoziiert und kausal in Zusammenhang gebracht. Dieses Lernen durch Konditionierung funktioniert in einfachen Umgebungen auch recht zuverlässig. Sie ist zwar ebenso für das Entstehen von Aberglauben und anderen Mythen verantwortlich, aber für die simplen Dinge des Überlebens ist die Methode sehr wirkungsvoll. Wenn es blitzt, ist der Donner nicht weit und wir suchen Schutz. Sieht der Jäger den frischen Hufabdruck eines Wildschweins, spannt er den Hahn seines Gewehrs. Jedoch führt diese Konditionierung auch zu unsinnigem Scheinwissen. Viele Fußballfans schauen sich das Spiel der Lieblingsmannschaft nicht an, weil sie glauben, dass dies Unglück bringt. „Beim letzten Mal, als ich das Spiel verpasst habe, haben wir gewonnen.“ Genauso rasieren sich viele Spieler nicht, weil sie nach zwei Siegen mit unrasiertem Kinn an eine Siegesserie glauben, die von ihrem Bartwuchs abhängig ist.

In komplexeren Bereichen wie sozialen und wirtschaftlichen Systemen allerdings führen uns unsere Lernmethoden regelmäßig in die Irre. Diese Erkenntnis ist noch nicht Allgemeinwissen geworden. Denn das Erleben der Manager gibt nur bedingt Hinweise darauf. Man (er)findet ja im Nachhinein immer Gründe, warum Dinge so passiert sind. Doch das Erleben ist trügerisch, weil es denselben einfachen Lernregeln folgt. Warum soll man auch die Art und Weise, zu lernen und zu managen, ändern, wenn man doch bislang einigermaßen erfolgreich war?

Die Antwort auf diese Frage finden wir im Relativitätsprinzip der Wirtschaft. Es kommt nicht darauf an, absolut richtig zu liegen, absolut schnell, billig oder schlau zu sein. Es kommt lediglich darauf an, besser zu sein als andere. Schlechte Ursachenanalysen sind nur ein Problem, wenn andere besser sind. Der Einäugige ist unter den Blinden König.

Diese Überlegungen zeigen, welche immensen Potenziale wir anzapfen können, wenn es uns gelingt, die wahren Erfolgstreiber auch und gerade in komplexen Sachverhalten zu ermitteln.

- „Wie könnte ich meinen Gewinn steigern, wenn mein Unternehmen als einziges ermitteln könnte, welche spezifischen Hintergründe hinter dem jüngsten Umsatzrückgang der Branche stehen?“

- „Wie schlagkräftig und Budget sparend könnte ich meine Kunden gegen das Werben der hungrigen Konkurrenz immunisieren, wenn ich allein die wirklich „erogenen Zonen“ der Kundschaft identifizieren kann?“

- „Wie viel profitabler und wachstumsstärker würde mein Unternehmen, wenn nur ich wüsste, welche 50% meiner Werbeausgaben bislang vergeudet werden?“

- „Welche Anziehungskraft würde mein Unternehmen für Talente und High Potentials entfalten, wenn ich im Kern wüsste, welche versteckten Hebel neben dem Gehalt für diese faktisch relevant sind?“

- „Welche Gewinnexplosion könnte mein produzierendes Unternehmen auslösen, wenn durch bessere Vorhersage von Rohstoffpreisentwicklungen deutlich billiger mit weniger Kapitalbindung eingekauft würde?“

Die zentrale Bedeutung brauchbaren und zuverlässigen Wissens scheint evident. Ziel muss es also sein, Methoden zu finden und einzusetzen, mit denen es möglich ist, dieses so nötige Wissen zu erlangen.

Der Methodenkanon

Der Rohstoff des Lernens sind Erfahrungswerte. Lernen bedeutet Wissen gewinnen. Erfahrungswerte sind lediglich Fakten, Zahlen, Erlebnisse. Immanuel Kant hat den Satz geprägt: „Erfahrung ist die einzige Quelle der Erkenntnis.“ Wenn wir nicht auf Erfahrungen aufbauen, dann bauen wir auf vorhandenem Wissen oder Annahmen auf. Diese sind ebenso zuvor durch Erfahrungswerte gebildet worden. Jedoch ist das vorhandene Wissen, sofern es konventionell erworben wurde, wie gezeigt, oft chronisch verzerrt oder einfach falsch. Daher sind Methoden, die unser Wissen zuverlässiger machen, immer Methoden, die intelligenter mit Fakten, Zahlen und Erlebnisberichten umgehen.

Wenn ich von „echtem“ Wissen spreche, meine ich eben nicht nur Zahlen und Fakten. Natürlich können wir auch die im Kopf haben. Dennoch sind sie für mich Informationen oder Rohdaten, auf sich allein gestellt, noch kein Wissen. Unter Wissen verstehe ich die Kenntnis von Ursache-Wirkungs-Relationen. Ich verstehe darunter, dass man weiß, welche Maßnahme zu welchem Ergebnis beitragen wird. Dieses kausale Wissen lässt sich nur erwerben, indem man aus Beispielen lernt, dass bestimmte Maßnahmen bestimmten Folgen auslösen. Man muss also Input und Output beobachten, um durch Analyse Wissen ableiten zu können.

Welche Methoden sind praktikabel? Wie steht es beispielsweise mit geschicktem Aufbereiten von Erfahrungswerten? Hier können wir einen sogenannten Gruppenvergleich bemühen. An einem Beispiel lässt sich zeigen, wie er funktioniert und warum er nicht funktioniert:

Wie unterscheiden sich erfolgreiche Unternehmen von schlechter aufgestellten hinsichtlich der Ausprägung ihrer Erfolgstreiber? Der Gruppenvergleich stellt fest, dass erfolgreichere im Schnitt größer sind. Außerdem arbeiten sie eher mit einem ein ERP-System oder treiben mittels eines R&D-Budgets Forschung und Entwicklung voran. Bringt das eine gesicherte Erkenntnis über Erfolgsursachen? Vielleicht sind es einfach Folgen. Vielleicht sind es Resultate anderer Treiber wie etwa der Unternehmenskultur. Wenn es keine Treiber sind, dann wird die aktive Steuerung der Größen nicht den gewünschten Effekt bringen.

Das Gleiche gilt für sogenannte Korrelationsanalysen. Diese berechnen den Gleichlauf zwischen zwei Variablen und liefern ähnliche Ergebnisse wie die Gruppenvergleiche.

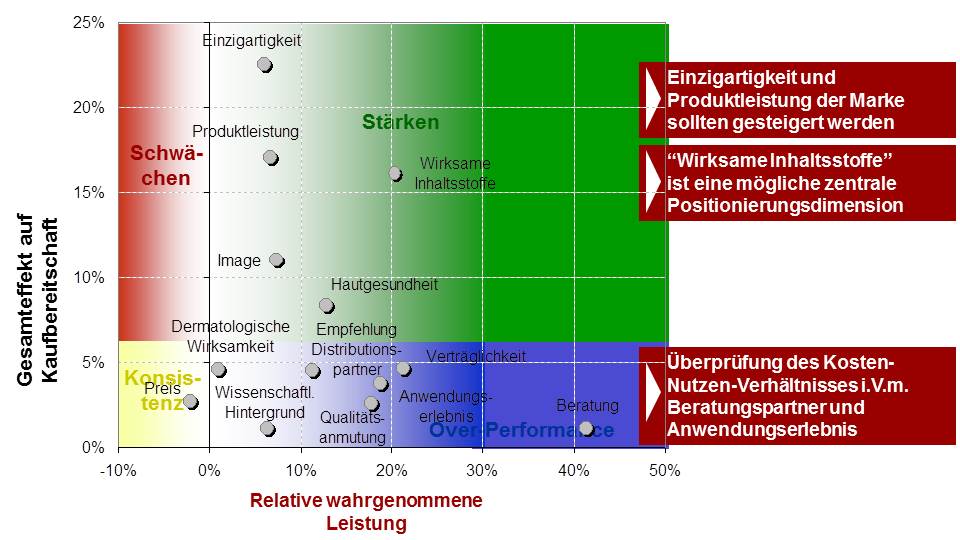

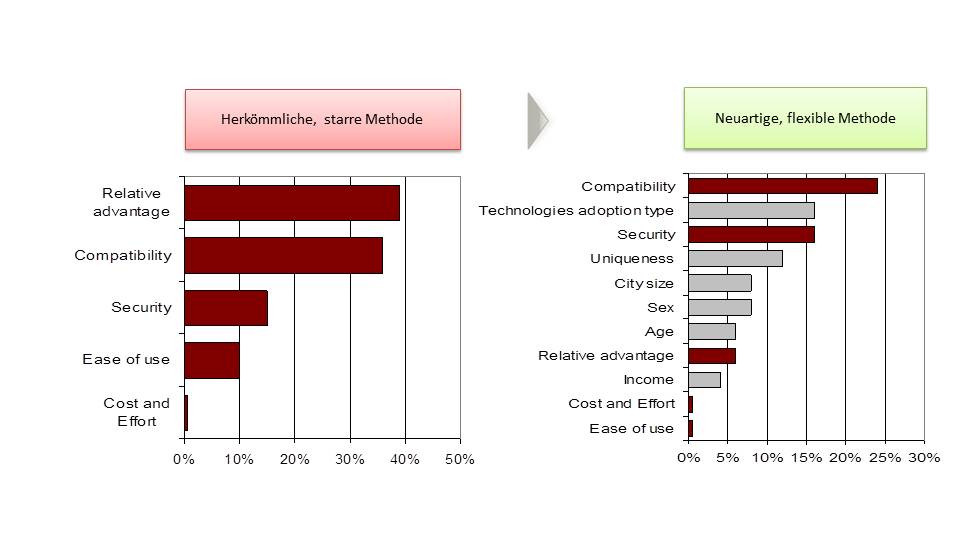

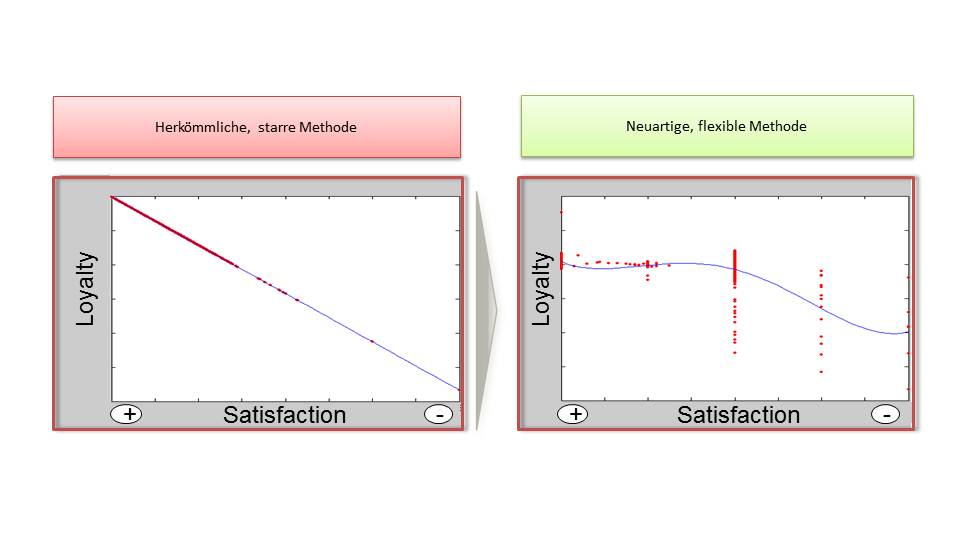

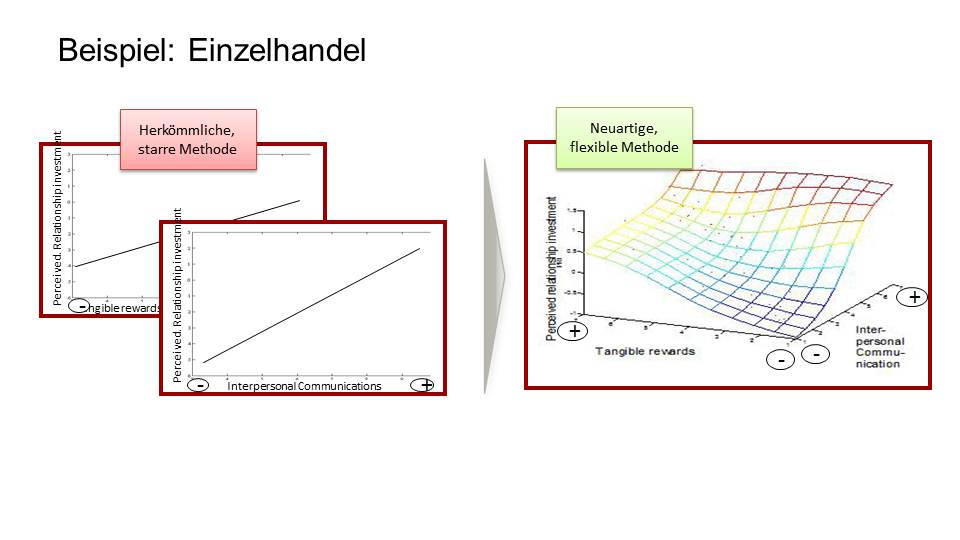

In der folgenden Grafik sind Ergebnisse aus der Kosmetikindustrie beispielhaft dargestellt. Sie stellt die Erfolgstreiber von Pflegeprodukten dar. Ein schneller Blick offenbart, dass Korrelationen (links) in diesem Fall kaum irgendetwas über die Realität erzählen, wenn wir diese mit den Ergebnissen einer geeigneten mehrdimensionalen Ursachenanalyse vergleichen, für die ich aus praktischen Gründen plädiere.

Wenn wir beide Seiten aufmerksam studieren, stellen wir gravierende Unterschiede bei jedem Erfolgstreiber fest. Wer sein Budget nach der Korrelationsmethode verteilt, verliert unter Umständen viel Geld.

Vergessen wir also Korrelationen. Vergessen wir Gruppen und sogenannte Top2-Vergleiche. Vergessen wir simples Benchmarking. Es sagt einfach nicht viel über Ursachen. Wir haben auch im vorherigen Kapitel viele andere drastische Beispiele gesehen. Egal wie intelligent wir Fakten aufteilen oder aggregieren – es ist auf diesem Weg nicht möglich, die partiellen Einflussfaktoren zu korrekt zu separieren.

Kontrollierte Experimente

Eine wirklich funktionierende Methode, korrektes Wissen über Ursache-Wirkungs-Zusammenhänge zu erhalten, ist das Experiment. Ausprobieren ist die bewährte Technik, die die Evolution verwendet. Hochkomplexe Lebewesen sind so entstanden – und dies in einer Komplexität und Leistungsfähigkeit, die wir Menschen mit heutiger Technik noch immer nicht nachbauen können. Genauso wie die biologische Evolution funktioniert auch die Evolution von Wissen, Wertesystemen, Glaubensrichtungen und Legenden. Solche, die weitergeben werden und sich somit reproduzieren, überleben. Der große Haken an der biologischen Evolution ist, dass sie sehr lange Zeiträume zur Verfügung hat. Ihr zweiter Haken ist, dass manche Fehlversuche drastisch bestraft werden. Die soziale Evolution führt langfristig zu guten Ergebnissen für die Gesellschaft. Braucht man aber als Individuum oder als

einzelnes Unternehmen Erfolgswissen, muss man vorsichtiger vorgehen, um der Evolution nicht zum Opfer zu fallen. Alles Ausprobieren hat seine Grenzen. Ist ein anderer schneller, verlieren wir. Powern wir viel Geld und Hoffnung in ein zu gewagtes Marktexperiment, verlieren wir auch.

Das Experiment an sich ist jedoch grundsätzlich die beste Methode, um etwas über Ursache-Wirkungs-Zusammenhänge zu lernen. Wann immer es im Hinblick auf Kosten und Risiken vernünftig ist, sollte man Experimente anderen Methoden vorziehen. Denn wenn zwei Größen konsistent korrelieren und eine davon durch unsere Maßnahme hervorgerufen wurde, dann ist ein kausaler Zusammenhang sehr wahrscheinlich. Praktisch gesprochen: Wenn ein Hammer auf meinen Finger fällt, könnte es mit viel Phantasie ja auch sein, dass eine geheime Schmerzsehnsucht den Hammer magnetisch anzieht. Dann wäre die Sehnsucht die Ursache und nicht die Gravitation. Wenn ich den Hammer jedoch in einem bestimmten Moment bewusst und willentlich auf meinen Finger schlage, kann ich ziemlich sicher sein, dass der darauf folgende Schmerz sehr wahrscheinlich durch den Hammer verursacht wurde – und nicht umgekehrt. Experimente kontrollieren die Wirkungsrichtung der möglichen Ursachen.

Das Experiment ist auch eine starkes Verfahren, um die Effekte, die mehrere Treibergrößen haben, voneinander zu trennen. Denn genauso, wie man eine Ursache aktiv verändern kann, um die Wirkung zu beobachten, so kann man zeitgleich eine zweite Ursache konstant halten. Wenn in Ihrem PC einer von zwei Speicherriegeln defekt scheint, bauen Sie einen aus. Läuft das Gerät dann wieder, ist der ausgebaute Arbeitsspeicher Ihr Übeltäter. Bricht der Start erneut ab, tauschen Sie die Riegel. Wenn Ihr Rechner jetzt wieder funktioniert, halten die den Übeltäter in den Händen. Durch dieses einfache Experiment können Sie den Einsatz eines teuren Technikers sparen.

Die Werbung macht es vor

In der Tat gibt es einige Bereiche in der Wirtschaft, in denen häufig mit Experimenten gearbeitet wird. Werbetests sind ein typisches Beispiel. Plakate oder Anzeigenwerbung werden in Teststudios getestet und variiert, bevor sie gelauncht werden.

Auch die Messung von Kundenpräferenzen wird regelmäßig in so genannten Conjoint-Measurement-Experimenten durchgeführt. Hierbei variiert man systematisch die Eigenschaften eines Produktes in der Produktbeschreibung und befragt den Kunden, inwieweit er dieses Produkt gegenüber Vergleichsprodukten bevorzugt. Sowohl Plakattests als auch Conjoint-Experimente sind quasi eine Art Trockenschwimmen, weil sie keine Tests in der Realität darstellen. Das Vorgehen büßt zwar ein Stück Validität ein, ist aber erheblich günstiger als ein Live-Test.

Echte Live-Tests sind üblich beim Optimieren von großen Direct-Mailing-Kampagnen. Objekt der Optimierung ist hier zum einen die Gestaltung des Anschreibens und zum anderen die Selektion der anzuschreibenden Kontakte. Denn in Direkt-Mailing-Kampagnen werden Briefe nicht an alle Kontakte in der Datenbank geschickt, sondern nur an Adressen mit hoher Responsewahrscheinlichkeit. Indem man nun zusätzlich einige Mailings an zufällig (oder strukturiert) ausgewählte Kontakte sendet, bekommt man durch deren Rücklaufquote eine Kontrollgröße, die es erlaubt, die Schätzung der Antwortwahrscheinlichkeit zu optimieren. Jeder Brief an einen zufällig (oder strukturiert) ausgewählten Kontakt ist ein Experiment.

Aber auch in anderen Bereichen sollte man Experimente in Erwägung ziehen, wie etwa bei der Standortwahl, der Art und Weise, wie man im Vertrieb auftritt, oder bei der Entwicklung neuer Angebote.

Worauf sollte man bei der Durchführung von Experimenten achten?

- Schritt 1: Alle zentralen Erfolgsgrößen aus bisherigem Wissen zusammentragen

Bei einem Experiment geht es darum, die Effekte verschiedener Ursachen zu bewerten und zu separieren – also voneinander zu trennen. Eine Ursachenanalyse ist immer nur dann valide, wenn alle Ursachen kontrolliert, also gemessen, gesteuert oder konstant gehalten werden. Daher ist es immer notwendig, sich vor einem Experiment Gedanken darüber zu machen, welche Ursachen es möglicherweise geben könnte.

Ich werde oft gefragt: „Was ist, wenn ich eine wichtige Ursache vergesse?“ Die Antwort ist einfach: Es gibt keine Alternative zu diesen Methoden der Analyse von

Ursachen-Wirkungs-Zusammenhängen. Wenn wichtige Faktoren fehlen, laufen wir zwar Gefahr, einige Scheinerkenntnisse zu erhalten, aber positiv ausgedrückt haben wir die besten Erkenntnisse, die man in diesem Moment erlangen kann. Der Prozess der Ursachenanalyse wird immer unvollständig und in Teilen fehlerhaft bleiben. Es ist philosophisch gesehen unmöglich, die Realität in Perfektion zu verstehen. Darum geht es auch nicht. Es geht immer nur darum, weniger Fehler zu machen. Nach dem alten Muster weiterzumachen bedeutet, mehr Fehler zu machen und mehr Geld „zu versenken“.

- Schritt 2: Experimental-Design erstellen:

Sind alle möglichen Ursachen bekannt, gilt es, die Treiber systematisch zu variieren, um den Effekt, den jeder einzelne von ihnen verursacht, herauszufinden. Zusätzlich existieren immer externe Ursachen, die man nicht selbst variieren kann. Diese muss man zumindest messen, um hinterher zu kontrollieren, ob einer der Effekte vielleicht durch einen parallel laufenden, externen Faktor verursacht wurde.

Haben die jeweiligen Ursachen nur zwei grundsätzliche Ausprägungen wie „niedrig und hoch“ oder „ja und nein“, so kann man bei zum Beispiel zehn Ursachen die Anzahl ihrer Kombinationen für die Messung ihrer alleinigen Wirkung auf elf begrenzen. Die Zahl steigt leider, wenn es mehr Ausprägungen werden. Und sie steigt weiter deutlich: Will man gleichzeitig die Interaktionen zwischen Ursachen erfassen, so ergeben sich mehr Kombinationen. Als Interaktion bezeichnet man die Tatsache, dass eine Ursache die Art und Weise, wie eine andere Ursache wirkt, beeinflussen kann.

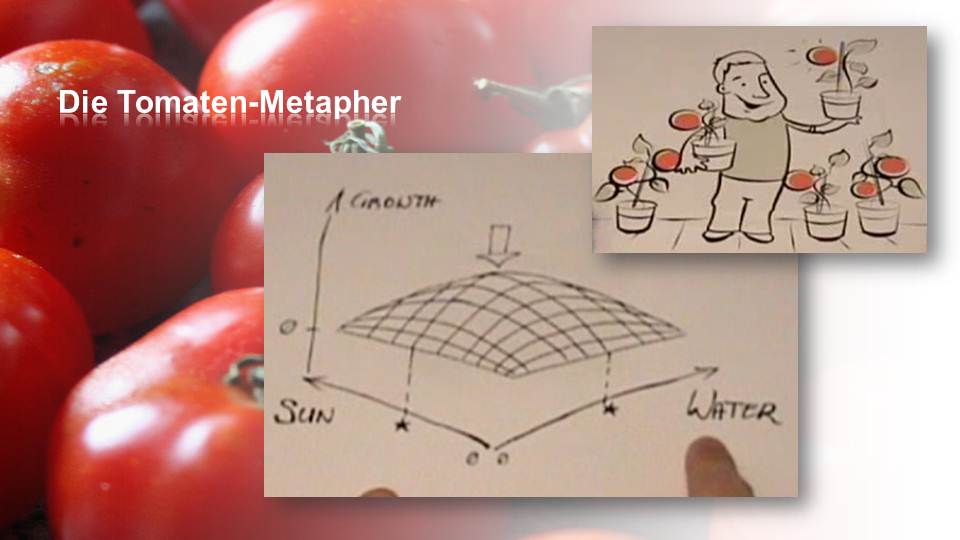

Ein typisches Beispiel: Die Erfolgsfaktoren für das Wachstum einer Pflanze sind Wasser und Sonne. Wasser allein hat keinen positiven Einfluss, solange kein Licht vorhanden ist. Ist zu viel Sonne da, verbrennt die Pflanze, selbst wenn reichlich Wasser zur Verfügung steht. Die beiden Erfolgstreiber beeinflussen sich gegenseitig in ihrer Wirkung.

Will man die Interaktionen von zwei Treibern mit zwei Ausprägungen messen, ergeben sich vier (22) weitere Kombinationen. Hat man jedoch zehn Treiber und zehn Ausprägunngen hat man 10 Milliarden Kombinationen (1010).

Wie man sieht, wird es noch schlimmer, wenn die Treiber mehr als nur zwei Zustände (ja/nein) annehmen können. Dann steigt die Komplexität derart stark, dass man Interaktionen nur noch sehr selektiv begutachten kann. Auch für die Analyse der separaten Einflüsse je Treiber, muss man höhere Mathematik anwenden. Man erstellt dann so genannte orthogonale Designs[1].

- Schritt 3: Durchführen, Wiederholen und Auswerten:

Steht das experimentelle Design, geht es in die Durchführung. Hierbei kommt es es unter anderem darauf an, dies „sauber“ zu tun. Als Negativbeispiel kann das berühmte „zählende Pferd“ gelten. Sein Besitzer war fest davon überzeugt, dass sein Tier zählen konnte. Dies bestätigten viele Augenzeugen. Als Wissenschaftler dem „Wunder“ nachgingen, brach für den Besitzer eine Welt zusammen. Sein Ursprungsexperiment sah wie folgt aus: Er sagte dem Pferd eine Zahl, und das Pferd begann daraufhin, solange mit den Hufen zu schlagen, bis die Zahl erreicht war. Das funktionierte auch tatsächlich wie von Zauberhand. Leider hörte das Pferd nicht deswegen auf zu klopfen, weil die genannte Zahl erreicht war, sondern weil der Besitzer beim Erreichen aufschaute. Das Pferd hatte gelernt: Wenn es aufhört zu klopfen, sobald sein Besitzer den Blick von seinen Hufen nimmt, gibt es als Belohnung „lecker Möhrchen“.

Externe Faktoren und Korrelate während des Experiments können also leicht verfälschen. Dies gilt es immer zu beachten. Weiterhin müssen in der Regel für jede Kombination der Ursachen mehrere Versuche durchgeführt werden. Die Anzahl hängt ein wenig von der Streuung der Ergebnisse ab. Wenn ich mir mit dem Hammer aus Testgründen auf den Finger haue, um den Effekt zu untersuchen, dann wird das Ergebnis sehr konsistent sein. Im Allgemeinen gelten aber die klassischen Regeln der Statistik. Als Daumenregel aus der Praxis gilt (Statistiker würden mich für diese Aussage steinigen), dass ein Mittelwert aus 35 Erfahrungswerten eine brauchbare Stabilität ergibt.

Brauchbar bedeutet, dass die Ergebnisse zwar stark schwanken können, jedoch die abgeleitete Entscheidung die gleiche und daher stabil ist. Letztlich hängt die nötige

Stichprobe davon ab, ob eher Tendenzaussagen oder genauere Ergebnisse gefordert werden. Wenn ich wissen will, ob ein Hammerschlag weh tut, muss ich nicht genau die Schmerzintensität messen. In diesem Fall werden wenige Schläge reichen, um zu brauchbaren Ergebnisse zu kommen. Möchte ich hingegen wissen, ab welcher Grenze der Schmerz nicht mehr auszuhalten ist, muss ich meinen Daumen erheblich öfter malträtieren.

Digitale Spürhunde: Die multivariaten Ursachenanalyse-Verfahren

Auch Daten von Experimenten bedürfen einer nicht trivialen Auswertung, wenn mehrere Ursachen zeitgleich variieren. Genau dann hilft die deskriptive Statistik mit einfachen Kennzahlenvergleichen nicht mehr weiter.

Leider stößt das Experiment schnell an die Grenzen praktischer Machbarkeit. Oft finden wir in der Praxis 10, 20 oder gar 50 potenziell relevante Einflussfaktoren, die sich zudem meist nicht auf binäre (hoch/niedrig) Niveaus begrenzen lassen. Je strategischer die Fragestellung ist, desto teurer wird außerdem das Experiment. Wie teste ich im Experiment eine Unternehmenspositionierung? Wie eine Segmentierung? In vielen Fällen werden die Kosten für ein Experiment prohibitiv hoch. Sie werden teurer als die Kosten einer Fehlentscheidung.[2]

In solchen Fällen brauchen wir jenseits des Experiments andere Methoden – Methoden, die anhand von Daten praktikable Hypothesen über die Wirkung bestimmter Ursachen zulassen.

An einem einfachen praktischen Beispiel lässt sich zeigen, wie wir wahre Ursache-Wirkungs-Beziehungen aus Daten ableiten können. Dazu produzieren wir zunächst unsere Daten im Computer anhand von Excel-Formeln selbst. Denn nur so können wir sicher gehen, dass wir die tatsächliche Wahrheit – die tatsächlichen Wirkbeziehungen auch wirklich kennen.

Es geht um folgendes kleines Beziehungsnetzwerk: Werbung steigert die Absatzzahlen und der Absatz steigert die Markensympathie. Zeitgleich reduziert diese spezielle Werbung allerdings auch die Markensympathie ein wenig, da sie vom Kunden als leicht nervig wahrgenommen wird. Um dies abzubilden, schaffe ich drei Datenreihen: Ausgaben für Werbung, Absatzzahlen und Markensympathie. Diese Zahlenreihen bilde ich zufällig – also mit einem speziellen Würfel, der mir beliebige Nachkomma-Zahlen zwischen 0 und 1 ausspuckt.

Schritt eins ist die Initialisierung: Die Datenreihe für Werbung wird im ersten Schritt aus 1000 Zufallszahlen zwischen 0 und 1 erzeugt. Analog wird die Datenreihe „Absatzzahlen“ gebildet. Die Datenreihe „Markensympathie“ wird ebenso erzeugt, nur dass die Zahlen zwischen 0 und 0,5 schwanken.

Im zweiten Schritt simulieren wir die Wirkbeziehungen.

- Die resultierende Datenreihe „Absatzzahlen“ wird aus den initialisierten Werten „Absatzzahlen“ addiert mit den Werten für Werbung gebildet.

„Absatzzahlen“ = „Absatzzahlen“ – Initialisierung + „Werbung“

Die inhaltliche Bedeutung ist, dass die Absatzzahlen positiv von der Werbung beeinflusst werden. Hinzu kommen zufällige andere Einflüsse (die Initialisierungswerte).

- Die Markensympathie wird aus den dafür initialisierten Zufallswerten „Markensympathie“ plus „Absatzzahlen“ und minus der Hälfte der Zahlenreihe für „Werbung“ ermittelt.

„Markensympathie“ = „Markensympathie“ – Initialisierung + Absatzzahlen“ – „Werbung“/2

Inhaltlich bedeutet dies, dass die Markensympathie durch die Absatzzahlen positiv beeinflusst wird. Wer kauft, wird retrograd eine positivere Einstellung entwickeln. Jedoch wirkt die Werbung leicht negativ auf die Marken- sympathie. Scheinbar löst sie zwar Kaufakte aus – ist aber nicht besonders sympathisch.

Auf diese Weise erzeugt man 1000 Datensätze mit jeweils Werten für Werbung, Absatzzahlen und Markensympathie. Jetzt schauen wir uns mit Analyseverfahren diese Datensätze an und versuchen herauszufinden, wie „Werbung“ und „Absatzzahlen“ die Größe „Markensympathie“ beeinflussen.

Insbesondere interessiert uns, wie „Werbung“ auf „Markensympathie“ wirkt. Denn wie oben definiert, ist der direkte Einfluss von „Werbung“ auf die „Markensympathie“ negativ und nur der indirekte Einfluss positiv – dies, weil „Werbung“ ja den „Absatz“ positiv beeinflusst und der „Absatz“ anschließend die „Markensympathie“ verstärkt.

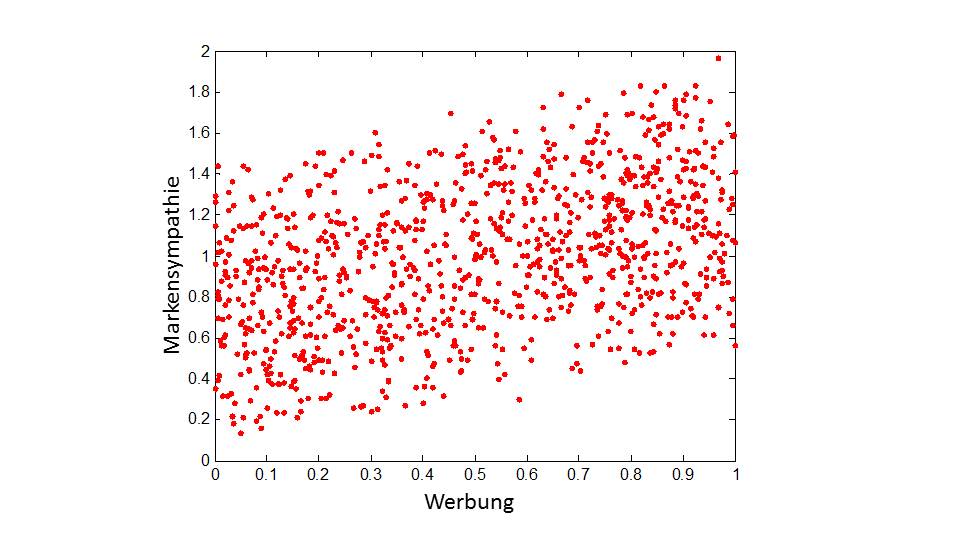

Jetzt berechnen wir den Korrelationskoeffizienten zwischen „Werbung“ und „Markensympathie“ und erhalten den Wert 0,42. In der Konsequenz hieße das: Je höher „Werbung“ desto höher „Markensympathie“. Schauen wir uns die Daten im zweidimensionalen Plot an.

Man sieht deutlich: Je höher der Wert für „Werbung“ desto höher ist der Wert der „Markensympathie“. Doch Halt! In Wahrheit beeinflusst doch Werbung die Markensympathie negativ. Ganz offensichtlich ist diese Zweivariablen-Analyse – egal ob Korrelationskoeffizient, graphische Analyse oder andere Auswertungen – nicht geeignet, die Wahrheit aufzudecken. Keine noch so elaborierte Zauberformel wird aus den dargestellten Zahlenpaaren die Wahrheit aufdecken können. Warum? Weil wichtige ursächliche Informationen fehlen.

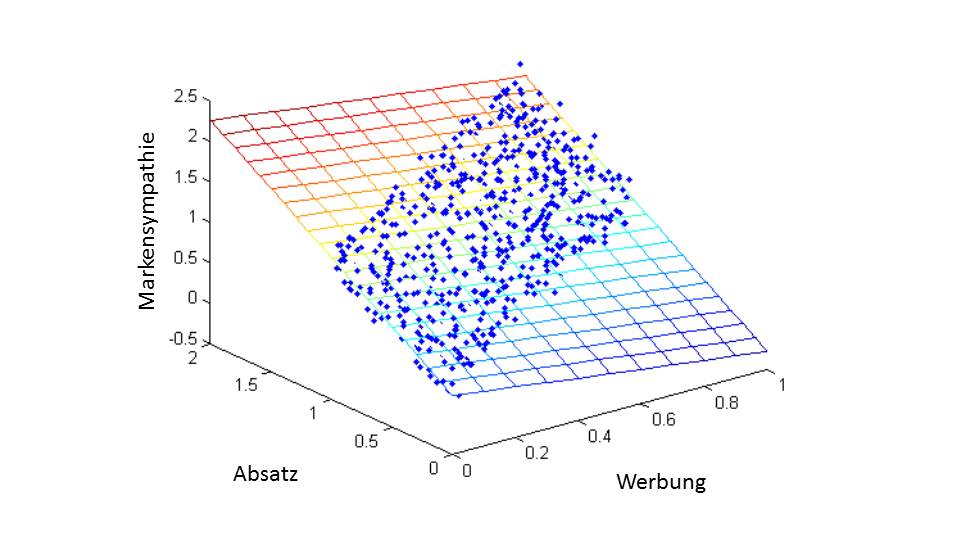

Irgendwie scheint diese Analyse direkte und indirekte Effekte zu vermengen. Diese indirekten Effekte können wir nur herausrechnen, wenn wir die Variablen einbeziehen, die dabei beteiligt sind. Also müssen wir die Daten nicht in einer zweidimensionalen, sondern in diesem Fall in einer dreidimensionalen Analyse anschauen. In der dreidimensionalen Betrachtung entsteht ein Analyseraum, in dem eine blaue Punktwolke dargestellt werden kann. Im zweidimensionalen Fall erkennen wir den Zusammenhang, indem wir mit dem Auge eine Linie durch die Punktwolken legen. Diese Linien zeigen im Beispiel oben nach oben – je mehr, je besser.

Haben wir jedoch eine dreidimensionale Punktwolke, müssen wir eine Ebene durch die Punktwolke legen.

Die blauen Punkte visualisieren den gleichen Datensatz – nur dass zeitgleich die Variable „Absatzzahlen“ mit dargestellt wird. An der Neigung der Ebene kann man nun den Effekt der Variablen „Werbung“ und „Absatzzahlen“ auf „Markensympathie“ ablesen. „Absatzzahlen“ wirken klar positiv auf die „Marken-sympathie“.

Jedoch wirkt „Werbung“ negativ. Das können Sie am besten dort ablesen, wo „Absatzzahlen“ den Wert Null hat. Je größer die Zahlen für „Werbung“ sind, desto mehr nähert sich die Ebene der „Werbung“-Achse. Das heißt, dass der direkte Zusammenhang wie folgt ist: Je größer die Ausgaben für Werbung sind, desto kleiner ist die Markensympathie.

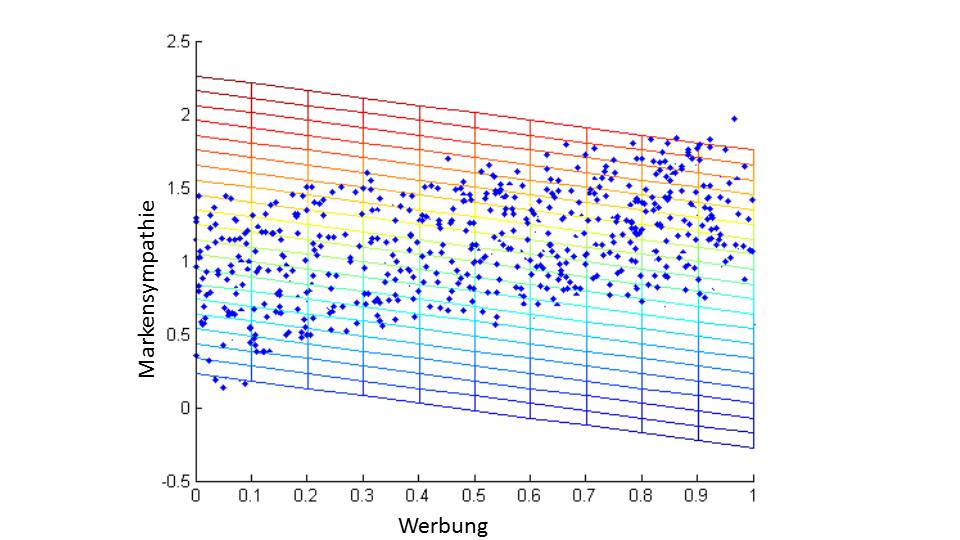

Das Legen einer mehrdimensionalen Ebene in eine mehrdimensionale Punktwolke nennt man multivariate, lineare Regressionsanalyse. Und sie ist prinzipiell für beliebig viele Treibervariablen anwendbar. Wenn Sie die dreidimensionale Grafik gedanklich so drehen, dass Sie von der Seite der „Werbung“ Seite darauf schauen, erhalten Sie wieder eine zweidimensionale Darstellung. Dies sieht dann so aus:

Die Punkte sind wieder genau die gleichen wie die roten Punkte in der ersten Abbildung. Die Gitter sind aus dem dreidimensionalen Graph entlehnt. Die abfallenden Linien sind Linien mit konstanten Absatzzahlen. Die Steigung entspricht genau dem Einfluss von „Werbung“ auf „Markensympathie“.

Wenn Sie bisher gewisse Probleme mit der dreidimensionalen Ebene hatten, dann seien Sie unbesorgt: Sie sind nicht allein. Meine Frau ist da auch nicht so gut darin (sie hat andere Talente). Auf Vorträgen veranschauliche ich das Ganze mit Cola-Flaschen und einem durchsichtigen Deckel von IKEA, wie das die nächste Abbildung zeigt.

Große Flaschen repräsentieren Zielkunden die eher kaufen, kleine Flaschen Zielkunden, die eher negativ denken. Der Platz, an dem die Flasche steht, sagt etwas darüber aus, wie der Zielkunde über die Marke denkt. Die lange Kante steht für den Preis, die kurze für die Markensympathie. Die kleine Flasche entspricht der Meinung Ottos, eines Kunden, der den Preis für schlecht hält und der die Marke ablehnt. Die Kundin Ilse hingegen ist mit dem Preis voll einverstanden, findet aber die Marke nur durchschnittlich. Die Regressionsanalyse legt einfach den Ikea-Deckel so auf die Flaschen, dass sie so gut wie möglich repräsentiert sind. An der Steigung der Deckelkanten kann man sehen, dass der Preis deutlich weniger wichtig ist als die Marke. So einfach ist multivariate Statistik. Nur, dass wir in der Praxis fünfzigdimensionale Deckel haben. Und weil es die nicht bei Ikea gibt, kosten die Analysen etwas mehr als ein Billy-Regal:

Die Regressionsanalyse ist eine Methode der multivariaten Ursachenanalyse. Multivariate Ursachenanalysemethoden betrachten mehrere Ursachen gleichzeitig und ermitteln in einer ganzheitlichen Betrachtung, welche Treiber welche Veränderung der Zielgröße tatsächlich verursacht haben.

Der Hauptnutzen dieser Analyse ist die Vermeidung von Scheinkorrelationen, da alle Ursachen gleichzeitig betrachtet werden. Die fatalen Folgen von falschem Wissen durch Scheinerkenntnisse haben wir bereits ausgiebig betrachtet.

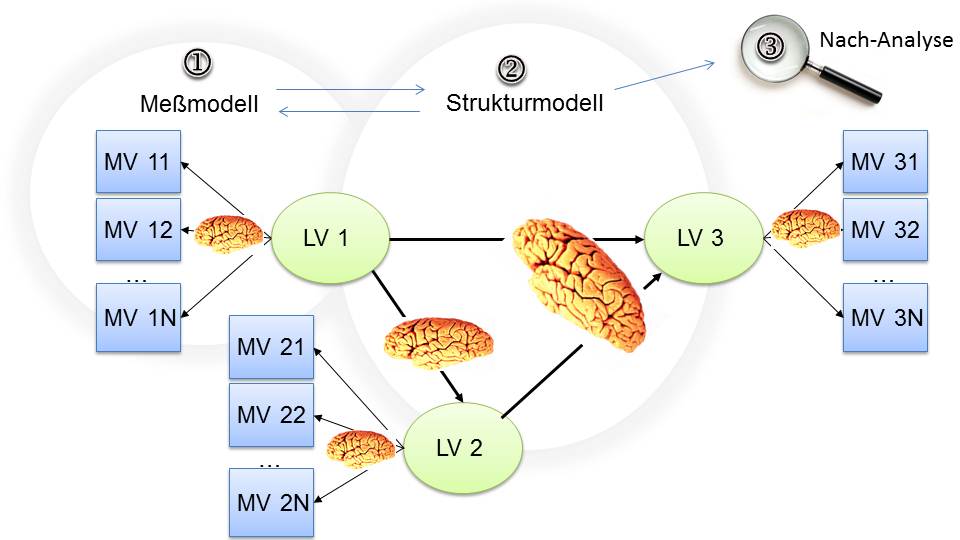

Die Regressionsanalyse veranschaulicht sehr schön den Lösungsansatz unseres Problems. Jedoch muss man noch einige weitere Anforderungen erfüllen, um in der Realität gute Ergebnisse zu erzielen. Daher brauchen wir eine verfeinerte Methode, deren Anforderungen wir in Kapitel 5 diskutieren.

Die multivariate Ursachenanalyse erfordert das Vorhandensein von Daten. Experimente durchzuführen, ist kosten- und zeitintensiv. Welche Methode sollte ich in welchen Situationen anwenden und in welchen nicht?

Der Prozess unserer Methodenwahl ist in folgender Abbildung skizziert. Am Anfang steht die Statusanalyse. Was sind meine Zielgrößen, was mögliche Treiber? Welche Kosten sind zu erwarten, wenn Experimente durchgeführt werden oder Beobachtungs- oder Befragungsdaten beschafft werden? Anhand dieser Informationen kann ich entscheiden, wie sinnvoll vorgegangen werden sollte.

Die Tabelle zeigt, dass das übliche Trial & Error ein fester Bestandteil auch des zukünftigen Managens bleiben wird. Sie zeigt aber ebenso, dass wir um die multivariate Ursachenanalyse nicht herumkommen, wenn wir es mit vielen Ursachen zu tun haben und in der Lage sind, Erfahrungswerte in Daten zu quantifizieren. Nur mit der multivariaten Ursachenanalyse ist es möglich, Scheinerkenntnisse zu vermeiden.

Dieses Kapitel demonstriert, wie schwierig sich die Ursachenanalyse schon bei wenigen Einflussgrößen gestaltet. In unserem Beispiel haben wir nur den Absatz, die Markensympathie und die Werbung betrachtet. Wir haben gesehen, dass es selbst bei derart wenigen Parametern bereits eine so große Menge möglicher Ergebnisse gibt, dass die „ideale Dosis“ Werbung ohne mathematische Unterstützung nicht ermittelt werden kann.

Es genügt schon ein flüchtiger Blick auf die reale Marktsituation eines Unternehmens, um festzustellen, dass es hier noch viel komplexer zugeht. Das Geschäft reagiert auf saisonale Einwirkungen, auf aktuelle wirtschaftliche Entwicklungen und auf viele andere Elemente mehr. Wenn diese echten Einflussgrößen mit anderen Elementen zusammenfallen, die nur scheinbar eine Ursache darstellen, jagen wir bereitwillig und oft relativ kritiklos Gespenstern nach.

Mit anderen Worten: In der Wirtschaft benötigen wir multivariate Ursachenanalysen, um uns von den Illusionen zu lösen, dass die Dinge so oder so funktionieren. Meistens funktionieren sie ganz anders, und wenn wir eine Investition tätigen, die auf einer solchen Illusion basiert, werfen wir gutes Geld zum Fenster heraus.

Was hier aber noch Theorie ist, wollen wir im nächsten Kapitel greifbar machen, indem wir konkrete Anwendungsbeispiele betrachten. Sie werden zeigen, dass die neuen Methoden nicht nur äußerst nützlich sondern, zunehmend erforderlich sind.

[1]Für weiterführende Informationen empfehle ich das Buch „Testing 1-2-3“ von Johannes Ledolter und Arthur Swersey.

[2]Siehe dazu eine ausführliche Diskussion in Buckler/Gibson „Do Causal Models Really Measure Causation?“, in: Marketing Research Magazin, Spring 2010

KAPITEL 4

Digitale Spürhunde im Einsatz: Anwendungsfelder multivariater Ursachenanalysen

Das Experiment ist die beste Methode, wenn die Anzahl der Ursachen begrenzt ist und die vergleichsweise hohen Kosten des Experiments den Nutzen rechtfertigen. Die Anwendungsbereiche liegen in der operativen Optimierung konkreter Marketing- und Vertriebsmaßnahmen. Dort finden sich vereinzelt Aufgabenstellungen mit mittlerer Komplexität und begrenzten Kosten, die durch Fehlversuche anfallen.

Die Anwendungsfelder multivariater Ursachenanalysen ohne Rückgriff auf Experimente sind vielschichtiger und befinden sich überall da, wo Manager echtes und verwendungsfähiges Wissen über Ursachen benötigen. Wenn das Experiment nicht praktikabel erscheint, muss unbedingt auf multivariate Ursachenanalysen zurückgegriffen werden. Die Voraussetzung dafür ist die Verfügbarkeit von Beobachtungsdaten. Ein Analyseverfahren benötigt immer eine „quantifizierte Erfahrungshistorie“. Dieses Wortungeheuer ist der wissenschaftliche Begriff für das, was wir einfacher als „Daten“ bezeichnen. Oft liegen diese Daten jedoch nicht vor, sodass der erste Schritt zu einem wirkungsvolleren Management im systematischen Sammeln und Speichern von ursächlichen Größen besteht. Die Kosten dafür sind im Vergleich zum Nutzen bei wichtigen Aufgabenstellungen fast immer überschaubar.

Weil die Anwendungsfälle, in denen keine Experimente möglich sind, in der deutlichen Mehrzahl sind, möchte ich mich im Folgenden auf solche fokussieren. Dies ist umso notwendiger, da deren Anwendungsfelder und Potenziale oft nicht offensichtlich sind. Die folgenden Fallbeispiele sollen veranschaulichen, wie und warum multivariate Ursachenanalysen in der Praxis angewendet werden.

Kundenmanagement

Markterfolg ist ein Ergebnis, das viele, sehr viele Ursachen und Bedingungen hat. Es gibt Millionen von Variationen in den Maßnahmen, die man ergreifen kann.

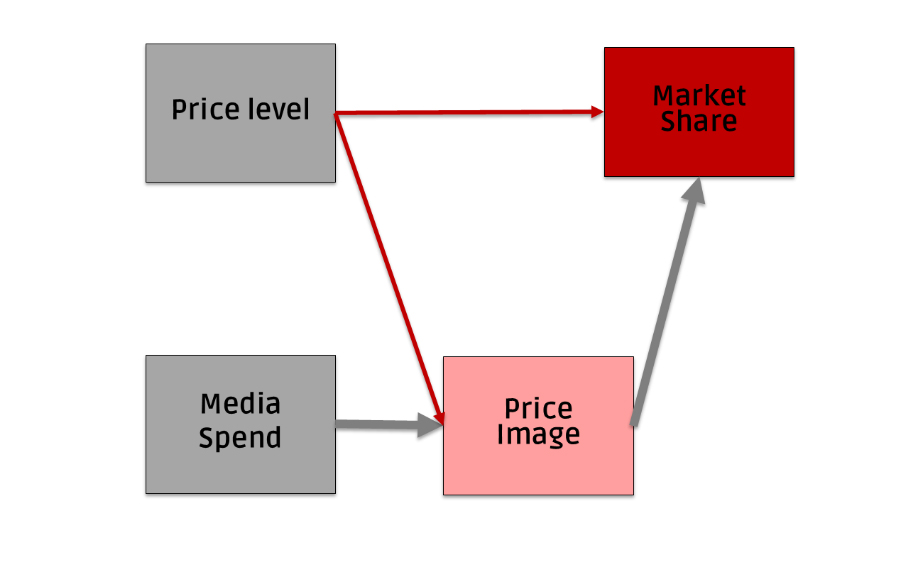

Die Klaviatur der Kanäle unterscheidet sich stark je nach Branche. Während im Konsumgüterbereich hier insbesondere Werbekanäle gemeint sind, sind es im Industriegüterbereich hingegen eher Vertriebsunterstützungsmaßnahmen. Neben der Frage, wie viel Geld in welche Kanäle fließen sollte, ist mit dem Marketing auch immer die wichtige Frage verbunden, was konkret der Inhalt der Werbung oder der Vertriebsunterstützungsmaßnahme sein sollten. Für die inhaltliche Optimierung haben sich Experimente als beste Methode bewährt, insofern eine praktikable Positionierung und Segmentierung vorliegt – mehr dazu später. Die Verteilung des Budgets auf Instrumente und Kanäle ist jedoch in den meisten Fällen zu komplex, sodass multivariate Verfahren sinnvoll eingesetzt werden.

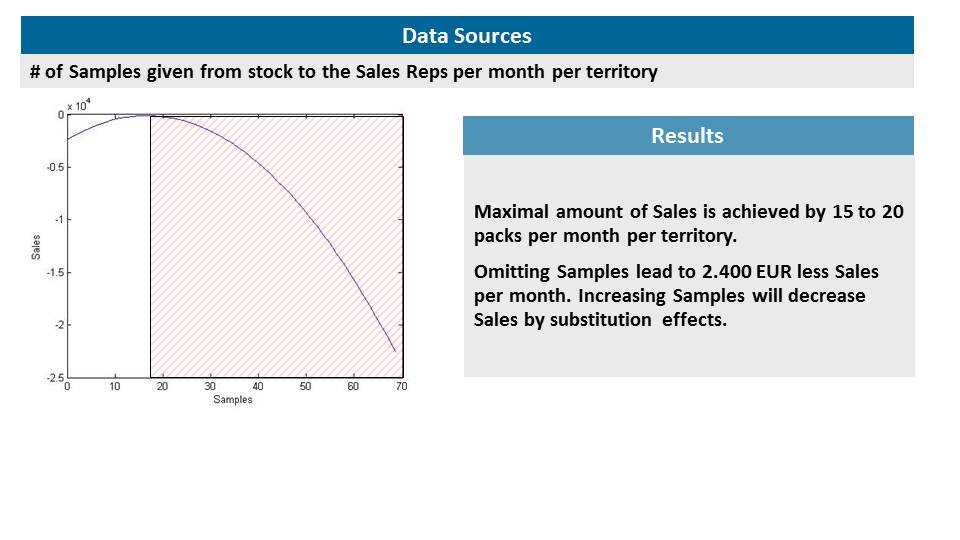

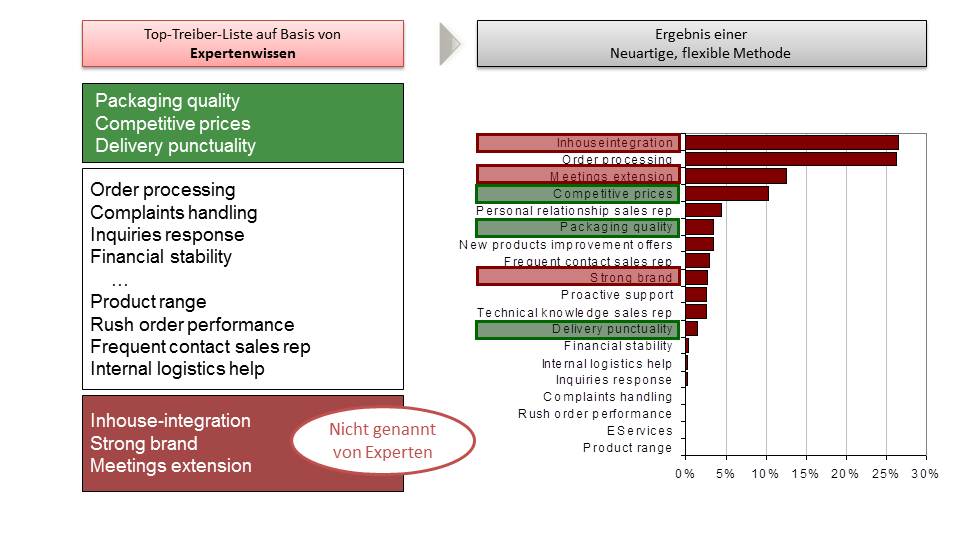

Fallbeispiel: Marketingbudgetverteilung im Pharmavertrieb

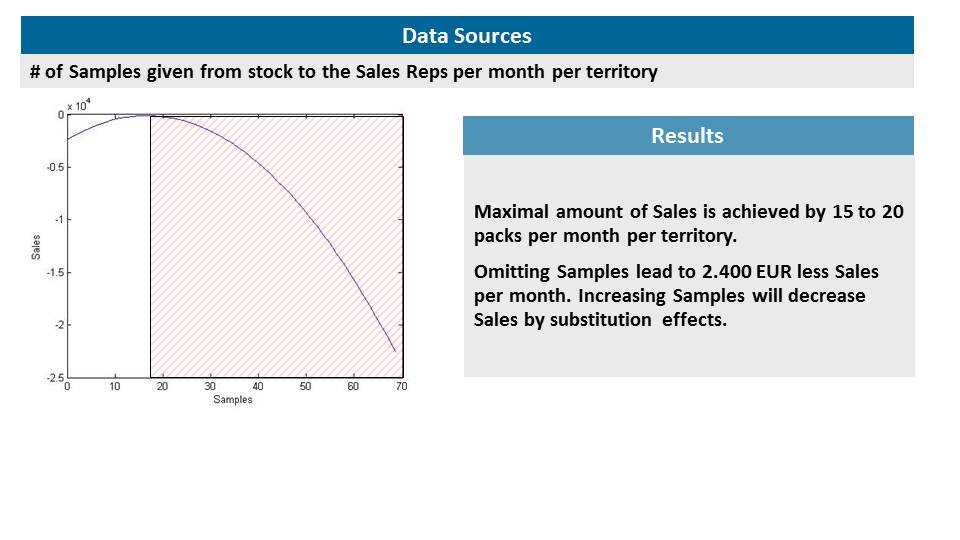

Ein Pharmaunternehmen, das verschreibungspflichtige Medikamente vertreibt, wollte die Verteilung seines Marketingbudgets optimieren. Marketinginstrumente sind hier die Anzahl der Besuche eines Vertriebsmitarbeiters bei verschreibenden Ärzten, die Anzahl der ausgegebenen Produktproben, die der Brand-Reminder (Kugelschreiber und andere Give-aways), Investitionen in Informationsveranstaltungen (lokale Workshops und Kongresse), für Werbeanzeigen in Fachzeitschriften und Produktproben in Krankenhäusern (dort werden Patienten auf Medikamente eingestellt, die daraufhin dauerhaft Verwender werden). Nicht zuletzt, spielt natürlich auch die Preisgestaltung eine große Rolle.

Die Situation im Unternehmen stellte sich wie folgt dar. Das Top-Management befragte das Marketing und die Vertriebsorganisation, ob diese die Wirksamkeit ihrer Ausgaben nachweisen können. Ein neues Schlagwort geisterte durch die Branche: Marketing-ROI. Leider musste man trotz vieler hoffnungsfrohen Versuche feststellen, dass dieser Return-on-invest letztlich nicht gemessen werden kann.

Doch wie wird die Budgetverteilung auf die Instrumente heute festgelegt? Meist folgt man, um es positiv auszudrücken, dem gesundem Menschenverstand. Erfahrungs-werten folgend wägt man ab und legt fest, welche Instrumente wie viel Budget erhalten. Oft hält man sich aber auch einfach daran, wie es andere machen und wie es bislang so üblich war. So unzuverlässig das anmutet, so schlecht ist es auch, und die

meisten Marketing-Manager haben Bauchschmerzen damit. Unbestritten bleibt in der Branche natürlich, dass es sinnvoll ist, Ärzte regelmäßig zu besuchen. Ob und wie viele Produktproben positiv wirken, ob und wie viele Kugelschreiber zu verteilen sind oder welche Werbung in Fachzeitschriften wann und wie zu schalten ist, ist nicht bekannt. Wenn aber, wie hier leicht zu sehen, die Wirkung der Anstrengungen unbekannt ist, kann man ziemlich sicher davon ausgehen, dass mit der klassischen Verteilung des Budgets viel Geld vergeudet wird.

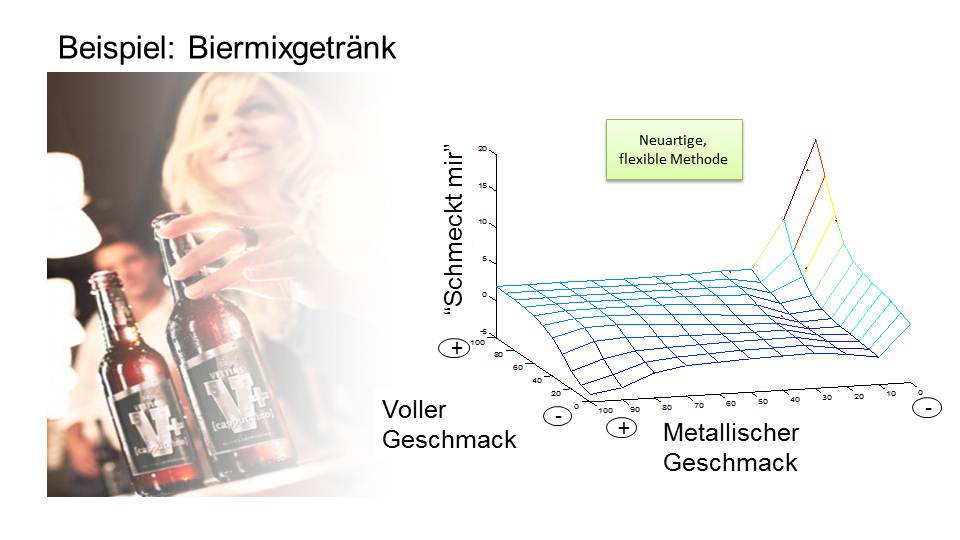

Aus diesen nachvollziehbaren Gründen startete das Unternehmen ein Pilotprojekt, in dem es den Zusammenhängen durch multivariate Ursachenanalysen auf den Grund gehen wollte. Nach einem eingehenden Auswahlverfahren wurde ich mit der Aufgaben betraut. Das Projektteam fand, wenig überraschend, heraus, dass die Wirkung vieler Instrumente schlichtweg nicht nachweisbar war. Werbung beispielsweise war wirkungslos. Brand-Reminder wie Kugelschreiber hingegen waren eine gute Ergänzung. Zudem konnte mein Team widerlegen, dass ein „Je mehr, desto besser“ bei Produktproben eine Erfolgsregel ist. Tatsächlich gibt es einen Punkt, ab dem zu viele Produktproben negative Effekte auf den Abverkauf haben. Der Grund dafür ist simpel. Wenn zu viele Proben im Umlauf sind geben Ärzte diese Proben statt einer Verschreibung an Patienten weiter. Produktproben stimulieren zwar den Abverkauf, sie substituieren diesen jedoch zeitgleich. Natürlich ist dieses Ergebnis für Branchenexperten mehr als plausibel. Jedoch waren diese Fachleute nicht in der Lage, den optimalen Punkt des Probeneinsatzes im Vorhinein zu benennen. Im Ergebnis unserer Untersuchungen konnten wir vorhersagen, dass eine Verdoppelung der Budgeteffektivität oder eine Halbierung der Marketingbudgets möglich war.

Fallbeispiel: Werbebudgetverteilung für einen Glückspielanbieter

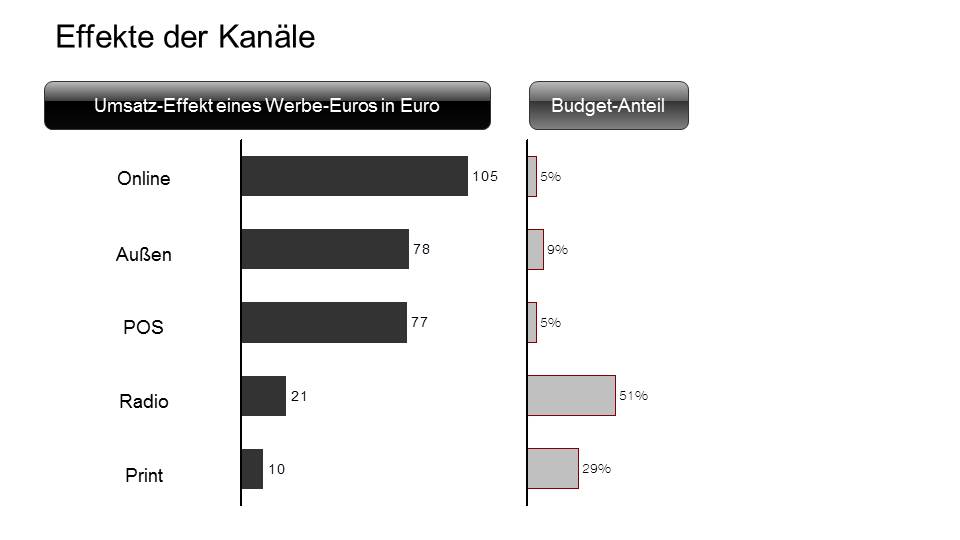

Die Situation bei einem Glückspielanbieter war angespannt. Seit Jahren sanken die Umsätze und der Geschäftsführer fragte sich zu Recht, ob die Werbemillionen richtig investiert waren. Im Losgeschäft sind die Werbekanäle zum einen klassische Medien wie Print, Plakat und Rundfunk, aber auch Einkaufsradio in Supermärkten sowie Werbung in den Verkaufsstellen und auf Webseiten. Die Mediaplaner legten die Werbeverteilung nach allgemeinen Glaubensätzen fest. Ein bekannter Glaubenssatz lautet beispielsweise, dass Radiowerbung die am schnellsten wirkende Werbung ist. Deshalb wird sie für Kurzfristthemen, wie etwa Jackpots, massiv eingesetzt, um den Umsatz zu steigern. Welcher Werbedruck jedoch genau benötigt wird, verraten diese Glaubenssätze nicht. Kein Wunder also, dass die im Unternehmen vorliegenden Zahlen extrem unpräzise waren.

Unser Team unterschied den Medieneinsatz nach den Inhalten der Werbung. Wurde ein Jackpot beworben, war es eine Imagewerbung oder war es eine Sonderaktion? Weitere wichtige Einflussgrößen waren die Höhe des Jackpots, die aktuelle Presseberichterstattung, die konkreten Wochentage und der Zeitpunkt im Monat.